AI代码生成器Copilot替代方案大盘点

在AI技术迅猛发展的今天,代码生成工具已经成为开发者日常工作中不可或缺的助手。GitHub Copilot作为这一领域的先驱,引领了AI编程助手的潮流。然而,随着市场竞争加剧和技术进步,Copilot不再是唯一选择。本文旨在为开发者提供一个全面的替代方案指南,帮助大家根据自身需求选择最适合的工具。本文将首先介绍AI代码生成的基本概念,然后分类盘点主流替代方案,深入分析它们的技术原理和使用方法,最后

AI代码生成器Copilot替代方案大盘点

关键词:AI代码生成、Copilot替代品、编程助手、代码补全、开发者工具、人工智能编程、开源代码生成

摘要:本文全面盘点GitHub Copilot的替代方案,从商业产品到开源工具,详细分析各类AI代码生成器的特点、适用场景和技术原理。我们将探索这些工具如何改变开发者的工作流程,比较它们的优缺点,并展望AI编程助手的未来发展趋势。

背景介绍

目的和范围

在AI技术迅猛发展的今天,代码生成工具已经成为开发者日常工作中不可或缺的助手。GitHub Copilot作为这一领域的先驱,引领了AI编程助手的潮流。然而,随着市场竞争加剧和技术进步,Copilot不再是唯一选择。本文旨在为开发者提供一个全面的替代方案指南,帮助大家根据自身需求选择最适合的工具。

预期读者

本文适合所有对AI编程助手感兴趣的开发者,特别是:

- 正在考虑使用AI代码生成工具的程序员

- 对Copilot价格或功能不满意的用户

- 希望了解不同AI编程工具技术差异的技术决策者

- 对AI辅助编程未来发展趋势感兴趣的研究者

文档结构概述

本文将首先介绍AI代码生成的基本概念,然后分类盘点主流替代方案,深入分析它们的技术原理和使用方法,最后探讨这一领域的未来发展趋势。

术语表

核心术语定义

- AI代码生成:利用人工智能模型自动生成或补全代码的技术

- 代码补全:在开发者输入时预测并建议后续代码的功能

- 上下文感知:工具能够理解当前代码文件的上下文并做出相关建议

相关概念解释

- 大语言模型(LLM):能够理解和生成人类语言(包括代码)的大型AI模型

- 微调(Fine-tuning):在特定数据集上进一步训练预训练模型以适应特定任务

- 提示工程(Prompt Engineering):精心设计输入提示以获取模型最佳输出的技术

缩略词列表

- IDE:集成开发环境

- API:应用程序编程接口

- VS Code:Visual Studio Code,流行的代码编辑器

核心概念与联系

故事引入

想象一下,你正在写一个复杂的函数,突然卡住了——就像写作时遇到"作家障碍"一样。这时,一个聪明的助手不仅能理解你的思路,还能提供恰到好处的建议,甚至完成整个代码块。这就是AI代码生成器的魔力!GitHub Copilot率先实现了这一愿景,但现在市场上已经涌现出许多同样强大(有时甚至更出色)的替代品。

核心概念解释

核心概念一:AI代码生成

就像有一个编程伙伴坐在你旁边,他能看到你写的代码,理解你的意图,并在你需要时提供帮助。不同的是,这个伙伴读过数百万行代码,掌握多种编程语言,而且永远不会累。

核心概念二:上下文感知

好比一个优秀的餐厅服务员,不仅记得你上次点的菜,还能根据你今天的穿着和心情推荐合适的菜品。AI代码生成器会分析你当前的文件、项目结构甚至最近的git提交,来提供最相关的代码建议。

核心概念三:模型微调

想象教一个会说多种语言的人专攻法律术语。通过微调,通用AI模型被训练得更擅长特定任务(如生成Python代码),就像专业人士在特定领域的专精。

核心概念之间的关系

AI代码生成和上下文感知

AI代码生成是核心能力,而上下文感知使这种生成更有价值。就像写作助手需要了解你正在写的小说类型和风格才能提供有用的建议。

上下文感知和模型微调

上下文感知能力部分来自于模型微调。通过让模型接触大量带有上下文的代码示例,它学会了如何利用这些信息生成更好的代码。

模型微调和AI代码生成

微调决定了AI代码生成的质量和风格。不同的微调方法会产生不同"性格"的代码生成器,有的更保守,有的更具创造性。

核心概念原理和架构的文本示意图

[开发者输入代码]

→

[上下文分析引擎]

→

[提示构造器]

→

[AI模型推理]

→

[结果过滤与排序]

→

[代码建议]

Mermaid 流程图

核心算法原理 & 具体操作步骤

现代AI代码生成器大多基于大型语言模型(LLM),如GPT系列、Codex等。下面是典型的工作流程:

- 上下文捕获:工具分析当前文件、导入的库、相邻代码等

- 提示构造:将上下文转换为模型能理解的格式

- 模型推理:模型基于提示生成多个候选建议

- 结果处理:过滤低质量或不安全的建议,按相关性排序

- 界面展示:将最佳建议显示给用户

以Python代码生成为例,以下是简化版的提示构造过程:

def build_prompt(file_content, cursor_line, cursor_pos):

"""

构造AI代码提示

:param file_content: 整个文件内容

:param cursor_line: 光标所在行号

:param cursor_pos: 光标在行中的位置

:return: 构造好的提示文本

"""

# 获取光标前的上下文

context = file_content[:cursor_line] + file_content[cursor_line][:cursor_pos]

# 添加语言标识和风格提示

prompt = f"""# Python代码补全

# 风格指南: 使用Python 3.9+语法,添加类型注解,包含docstring

{context}

"""

return prompt

数学模型和公式

AI代码生成的核心是基于语言模型的概率预测。给定上下文 ccc,模型预测下一个token xxx 的概率为:

P(x∣c)=exp(s(x,c))∑x′∈Vexp(s(x′,c)) P(x|c) = \frac{\exp(s(x,c))}{\sum_{x'\in V} \exp(s(x',c))} P(x∣c)=∑x′∈Vexp(s(x′,c))exp(s(x,c))

其中:

- VVV 是模型的词汇表

- s(x,c)s(x,c)s(x,c) 是token xxx 在上下文 ccc 下的得分

在代码生成中,常使用束搜索(Beam Search)来提高生成质量,其目标是找到最可能的序列:

y^=argmaxy∑t=1TlogP(yt∣y<t,c) \hat{y} = \arg\max_{y} \sum_{t=1}^T \log P(y_t|y_{<t}, c) y^=argymaxt=1∑TlogP(yt∣y<t,c)

其中 TTT 是生成序列的长度,y<ty_{<t}y<t 表示前 t−1t-1t−1 个token。

项目实战:代码实际案例和详细解释说明

开发环境搭建

以开源的CodeGen项目为例,搭建本地代码生成环境:

# 创建Python虚拟环境

python -m venv codegen-env

source codegen-env/bin/activate # Linux/Mac

# codegen-env\Scripts\activate # Windows

# 安装依赖

pip install torch transformers

pip install git+https://github.com/salesforce/CodeGen.git

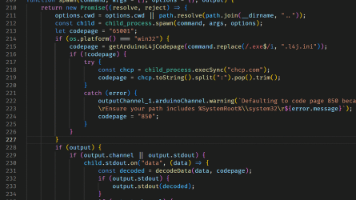

源代码详细实现和代码解读

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# 加载预训练模型和分词器

model_name = "Salesforce/codegen-350M-mono"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

def generate_code(prompt, max_length=100, temperature=0.7):

"""

生成代码补全

:param prompt: 输入提示

:param max_length: 生成的最大长度

:param temperature: 控制创造性的参数

:return: 生成的代码

"""

# 编码输入

inputs = tokenizer(prompt, return_tensors="pt")

# 生成代码

with torch.no_grad():

outputs = model.generate(

inputs.input_ids,

max_length=max_length,

temperature=temperature,

do_sample=True,

pad_token_id=tokenizer.eos_token_id

)

# 解码输出

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 示例使用

prompt = """def calculate_factorial(n):

'''

计算n的阶乘

"""

print(generate_code(prompt))

代码解读与分析

- 模型加载:使用Hugging Face的Transformers库加载预训练的CodeGen模型

- 分词处理:将自然语言提示转换为模型能理解的token序列

- 生成参数:

max_length:控制生成结果的最大长度temperature:值越高结果越多样但可能不准确,值越低结果越保守do_sample:启用随机采样而非贪婪解码

- 结果处理:跳过特殊token并将输出解码为可读代码

实际应用场景

- 快速原型开发:当需要快速验证想法时,AI生成器可以快速搭建基础代码框架

- 学习新语言/框架:通过观察AI生成的代码,加速学习过程

- 样板代码生成:自动生成重复性高的代码结构,如getter/setter方法

- 代码翻译:将代码从一种语言转换为另一种语言

- 文档生成:根据代码自动生成注释和文档字符串

工具和资源推荐

商业产品

- Tabnine:全功能AI助手,支持多种IDE,提供团队协作功能

- Amazon CodeWhisperer:AWS出品,深度集成AWS服务

- Codeium:免费增值模式,提供强大的代码搜索功能

开源方案

- StarCoder:BigCode项目开发的15B参数模型

- CodeGen:Salesforce开发的一系列代码生成模型

- InCoder:专注于代码补全和编辑的6B参数模型

在线平台

- Sourcegraph Cody:结合代码搜索的AI助手

- Replit Ghostwriter:在线IDE Replit的内置AI功能

未来发展趋势与挑战

- 多模态编码:结合文本、图表等多种输入生成代码

- 调试辅助:不仅能生成代码,还能帮助诊断和修复错误

- 个性化适应:学习开发者的编码风格和偏好

- 挑战:

- 代码版权和许可问题

- 生成代码的安全性问题

- 对开发者技能发展的长期影响

总结:学到了什么?

核心概念回顾:

- AI代码生成器通过理解上下文提供智能建议

- 不同工具在模型架构、功能集和集成方式上各有特点

- 从商业产品到开源方案,选择丰富多样

概念关系回顾:

- 模型能力决定了生成代码的质量

- 上下文理解使建议更相关

- 开发环境集成影响用户体验

思考题:动动小脑筋

思考题一:如果你要设计一个AI编程助手,会重点关注哪些功能?为什么?

思考题二:AI生成的代码可能存在哪些潜在风险?如何规避这些风险?

思考题三:在团队开发环境中,AI代码生成器可能带来哪些协作上的变化?

附录:常见问题与解答

Q:这些替代方案真的能媲美Copilot吗?

A:某些方面甚至超越,如Tabnine在私有代码处理上更安全,CodeWhisperer对AWS服务支持更好。但Copilot在语言支持和创造性上仍有优势。

Q:使用这些工具会降低我的编程能力吗?

A:如果仅依赖工具而不理解生成的代码,确实可能。建议将AI视为"结对编程"伙伴而非替代品。

Q:开源方案需要强大硬件吗?

A:较小模型可在消费级GPU上运行,但大模型需要专业硬件。云服务是另一种选择。

扩展阅读 & 参考资料

- 《The Rise of AI Pair Programmers》- ACM期刊

- Codex论文:《Evaluating Large Language Models Trained on Code》

- BigCode项目官网:https://www.bigcode-project.org

- Hugging Face模型库:https://huggingface.co/models

- AI代码生成器比较报告:Gartner 2023

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)