阿里通义千问重磅发布Qwen3-Coder:480B超大规模代码模型,支持256K上下文,AI编程进入“智能体”时代!

阿里通义实验室推出4800亿参数Qwen3-Coder系列AI编程模型,采用混合专家架构(MoE),支持256K上下文并可通过YaRN扩展至100万tokens。该模型在7.5万亿token数据上训练,代码占比70%,具备自主规划、工具调用等智能体能力,刷新开源模型记录。提供Qwen Code、Claude Code等多种集成方案,支持OpenAI兼容API调用。Qwen3-Coder标志着AI编

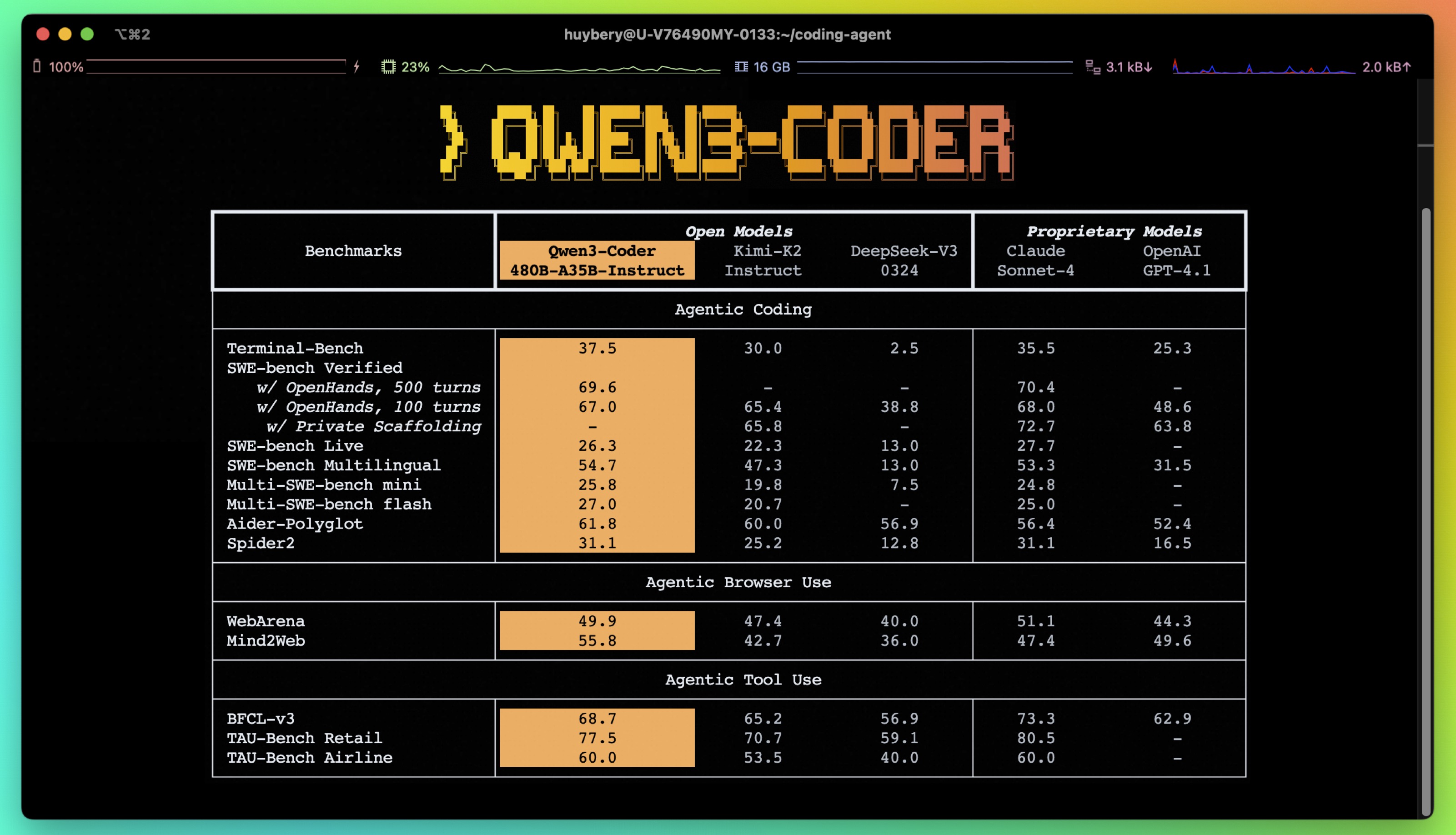

导语:2024年AI编程领域迎来重磅突破!阿里巴巴通义实验室正式推出Qwen3-Coder系列模型,其中最强版本Qwen3-Coder-480B-A35B-Instruct以4800亿参数、350亿激活参数的混合专家(MoE)架构,原生支持256K上下文,并可通过YaRN技术扩展至100万tokens,在代码生成、智能体(Agent)任务上全面刷新开源模型记录,性能比肩Claude Sonnet 4!这不仅是一次技术升级,更是AI从“辅助编程”迈向“自主开发”的关键一步。

一、什么是Qwen3-Coder?不只是代码模型,更是“编程智能体”

Qwen3-Coder是阿里通义千问团队推出的最新一代代码大模型,其核心定位已从“代码补全工具”进化为具备自主规划、工具调用、环境交互能力的“智能体”(Agentic AI)。

其旗舰版本 Qwen3-Coder-480B-A35B-Instruct 在多个维度实现了技术突破:

- 模型规模:480B(4800亿)参数,采用混合专家(Mixture-of-Experts, MoE)架构,每次推理仅激活35B(350亿)参数,兼顾性能与效率。

- 上下文长度:原生支持256K tokens,通过YaRN外推技术可扩展至1M tokens,轻松处理整个项目代码库、超长文档或复杂PR分析。

- 训练数据:在7.5万亿tokens的海量数据上训练,其中代码占比高达70%,同时保留强大的数学和通用能力。

- 智能体能力:在SWE-Bench等真实软件工程任务中,达到开源模型SOTA(State-of-the-Art)水平,无需测试时扩展(test-time scaling)即可高效完成多轮交互任务。

二、技术亮点:如何打造最强“编程智能体”?

1. 预训练:三大维度全面“Scaling”

Qwen团队在预训练阶段贯彻“大力出奇迹”的Scaling Law,从三个关键维度提升模型能力:

- Scaling Tokens(数据量):7.5T tokens的训练语料,70%为高质量代码,覆盖多种编程语言和开发场景。

- Scaling Context(上下文):256K原生上下文,专为“仓库级”(repo-scale)任务优化,可处理Pull Request、项目文档等动态数据。

- Scaling Synthetic Data(合成数据):利用Qwen2.5-Coder对噪声数据进行清洗和重写,显著提升训练数据质量,形成“模型自进化”闭环。

2. 后训练:长周期强化学习(Agent RL)是关键

传统代码模型在复杂任务中表现乏力,因为它们缺乏“试错-反馈-调整”的能力。Qwen3-Coder通过长周期强化学习(Long-Horizon RL) 解决这一难题。

在SWE-Bench(真实GitHub问题修复任务)中,模型需要:

- 多轮与环境交互

- 自主规划任务步骤

- 调用Git、编译器等工具

- 根据执行结果调整策略

为此,阿里团队构建了可并行运行20,000个独立环境的强化学习系统,依托阿里云基础设施提供大规模反馈,让模型在真实软件工程场景中“学会”如何编程。最终,Qwen3-Coder在SWE-Bench Verified榜单上创下开源模型最佳成绩。

三、开发者工具:Qwen Code、Claude Code、Cline 全面支持

为了让开发者快速上手,Qwen团队推出了多种工具链,无缝集成主流开发环境。

✅ 方案一:使用 Qwen Code(官方CLI工具)

Qwen Code是一款基于Gemini CLI改造的命令行工具,专为Qwen-Coder优化。

安装步骤:

# 1. 安装 Node.js 20+

curl -qL https://www.npmjs.com/install.sh | sh

# 2. 全局安装 Qwen Code

npm install -g @qwen-code/qwen-code

# 或从源码安装

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code && npm install && npm install -g

配置环境变量(获取API Key请访问 DashScope):

export OPENAI_API_KEY="your_dashscope_api_key"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

启动AI编程:

qwen

即可进入交互式编程模式,享受“vibe coding”新体验!

✅ 方案二:集成 Claude Code

如果你已经是Claude Code用户,也可以无缝切换至Qwen3-Coder后端。

方式1:代理API模式

export ANTHROPIC_BASE_URL=https://dashscope-intl.aliyuncs.com/api/v2/apps/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=your_dashscope_apikey

方式2:使用路由配置包(推荐)

# 安装路由工具

npm install -g @musistudio/claude-code-router

npm install -g @dashscope-js/claude-code-config

# 自动生成配置

ccr-dashscope

# 启动

ccr code

✅ 方案三:Cline 可视化配置

Cline用户可通过图形界面快速接入Qwen3-Coder:

- 打开Cline设置

- API Provider 选择 OpenAI Compatible

- 填入DashScope获取的API Key

- 勾选“使用自定义Base URL”,输入:

https://dashscope-intl.aliyuncs.com/compatible-mode/v1 - 模型名称填写:

qwen3-coder-plus

保存后即可享受Qwen3-Coder的强大能力。

四、API调用示例:快速集成到你的应用

你可以通过OpenAI兼容API直接调用Qwen3-Coder,代码如下:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

)

prompt = "帮我创建一个在线书店的网页,包含书名、价格和购买按钮。"

completion = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[

{"role": "system", "content": "你是一个专业的前端开发助手。"},

{"role": "user", "content": prompt}

]

)

print(completion.choices[0].message.content.strip())

五、未来展望:更小的模型、更低的成本、更强的自进化

Qwen团队表示,更多尺寸的Qwen3-Coder模型正在路上,将在保持高性能的同时降低部署成本。此外,团队正在探索“模型自我改进”的可能性——让AI不仅能写代码,还能不断优化自身,实现真正的“自进化”。

写在最后

亲爱的开发者朋友们,Qwen3-Coder的发布,标志着AI编程正式进入“智能体时代”。我们不再只是写代码,而是与AI协作,共同构建未来。

无论你是前端、后端、全栈还是算法工程师,Qwen3-Coder都可能成为你最强大的“编程搭档”。快来试试吧,让AI帮你解放生产力,专注更有创造力的工作!

期待在评论区看到你的使用体验与反馈!

#Qwen3-Coder #AI编程 #通义千问

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)