(长期有效)接入第三方 OpenAI 兼容模型到 GitHub Copilot

GitHub Copilot暂不支持直接调用OpenAI兼容API,现有两种解决方案:1)修改Copilot Chat源代码添加自定义模型选项,但存在版本兼容和打包问题;2)通过oai2ollama工具将OpenAI API封装为Ollama兼容接口,利用现有Ollama选项接入第三方模型。方法二操作简便,只需安装UV工具并运行转换程序,即可在Copilot中选择Ollama选项调用自定义模型。官

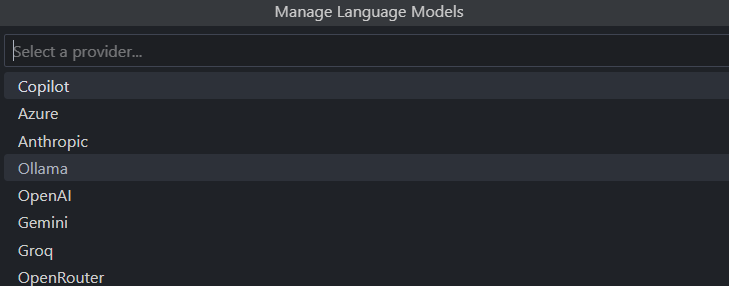

目前 GitHub Copilot 仅支持接入国外的几家模型提供商,无法直接调用 OpenAI 兼容的自定义 API 进行扩展。参考相关解决方案,我总结了一下Copilot中接入OpenAI 兼容 API 的方法。

实现方法主要分为两种:

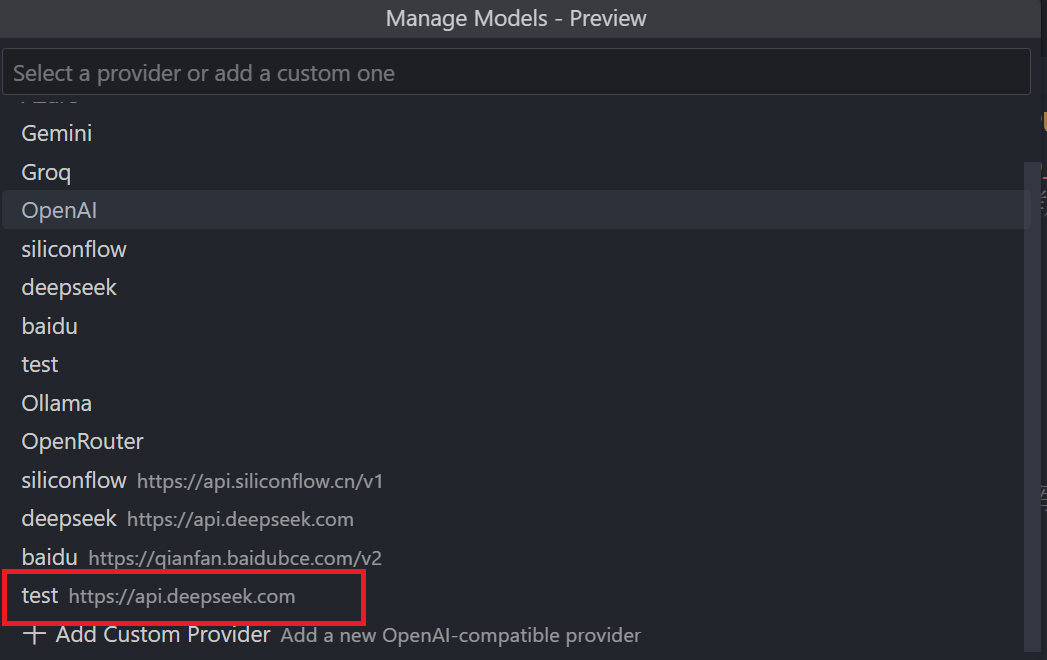

方案一:修改 Copilot Chat 源代码

在模型选择器中新增自定义提供商选项。

方案二:API 兼容适配

将 OpenAI 兼容的自定义 API 虚拟化封装为与 Ollama 兼容的 API(运行期间占用 Ollama 端口),从而利用 Copilot 模型选择器中原生的 Ollama 选项。

方法一(目前存在问题)

具体做法可参考修改Copilot chat插件增加自定义模型提供商

这里只说一下这个方法存在的问题:

- 官方开源的Copilot chat插件版本通常滞后于最新版,可能存在未来兼容性问题

- 打包过程的npm install环节容易报错,需要多次调试

- 重要 当前打包后的Copilot chat插件在VSCode中无法显示模型选择器。虽然原作者指出这是由于插件要求的VSCode最低版本与实际版本不匹配所致,但即便修改了package.json中的vscode版本号,问题依然存在。

方法二(长期有效)

这一方法基于Github上的oai2ollama项目,它通过命令行工具启动一个服务,将OpenAI兼容API封装为Ollama兼容API。特别适合为不支持自定义OpenAI API但支持Ollama的编码代理(如VS Code中的GitHub Copilot)提供自定义模型支持。

这一项目的灵感来源于vscode-copilot GitHub讨论区中关于添加自定义 OpenAI 端点配置(基础 URL 和模型参数)到协同聊天设置的讨论。值得注意的是,官方已采纳该提议,未来Copilot版本可能直接支持第三方模型。

言归正传,具体操作步骤如下:

-

安装UV工具

详细安装教程可参考:Windows系统UV安装及路径配置指南 -

运行转换程序

在命令行直接执行(无需本地下载项目):uvx oai2ollama --api-key your_api_key --base-url provider_base_url如需长期使用,可选择以下任一方式:

- 执行

uv tool install进行永久安装 - 创建批处理文件(双击运行):

@echo off powershell -NoExit -Command "uvx oai2ollama --api-key your_api_key --base-url provider_base_url" - 执行

-

配置VS Code

在Copilot模型选择器中选择"Ollama",稍候将显示第三方模型列表。

常见问题:若未显示模型列表,请检查命令行报错信息。多数情况下,在base-url末尾添加/v1即可解决。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)