AI编程:理解大模型的工作原理

《大型语言模型开发指南》系统介绍了LLM的核心原理与应用方法。主要内容包括:1)LLM工作原理与模型选择策略,强调不同模型适用于不同任务;2)基准测试解读,指出需结合实际需求评估模型能力;3)Cline平台模型选择方法,平衡速度、成本、上下文窗口等关键因素;4)模型提供商路由策略,涵盖直接连接、聚合器和本地部署三种方式。文章还提供了LLM学习资源包,包含经典书籍、行业报告、视频教程等资料,帮助开发

Chapter 1: LLM Fundamentals

主题:理解大型语言模型的工作原理,并在开发工作流中有效利用它们。

在 Cline 中首次设置时,选择语言模型提供商是开发工作流中最关键的决策之一,因为它直接影响结果质量。

大型语言模型(LLM)本质上是生成系统:当用户请求(如“为我的应用添加登录页面”)时,模型并非从数据库中检索预写代码,而是基于训练期间学习的模式生成全新代码。

不同模型具有根本不同的架构、训练数据集和优化目标,这些差异直接影响其能力和输出质量(例如,Claude Haiku 优化速度和成本效益,适合简单任务;Claude Opus 代表最先进的编码能力,适合复杂推理)。

模型选择不是“更好”或“更差”的问题,而是“不同工具适用于不同工作”的问题。

可用模型(如 Gemini 2.5 Pro、GPT-4、Qwen 3 Coder)各有优势:有的擅长理解现有代码库,有的擅长生成可维护代码,有的则擅长特定语言或框架。

Cline 中的模型是基础模型(Foundation Models),它们是大规模通用系统,训练在多样化数据集上,可适应多种任务(如分析业务需求、生成代码、调试问题、编写文档),这为 Cline 的广泛能力提供了支持。

基础模型引入变异性:针对不同任务优化的模型(如创意写作与编程)会以不同方式处理代码生成。

多模态能力(处理图像、音频等输入)在不同模型中差异显著:视觉问题(如修复 UI 错误)用多模态模型(如 GPT-4 Vision)更高效,而纯文本模型需依赖语言描述。

推理模型(如 OpenAI o1、Gemini 2.5 Pro)与非推理模型(如 GPT-4o)的根本区别:推理模型在生成代码前进行显式思考(如考虑安全漏洞和边缘情况),导致更全面但更慢的解决方案;非推理模型则快速生成响应,适合简单任务。

模型差异解释了价格变动:高能力模型(如 Claude Opus)因复杂推理和解决方案而溢价,经济型模型(如 Claude Haiku)则适合简单任务;关键在于匹配模型能力到具体需求。

Cline 的模型无关方法允许用户基于任务(如常规维护用快速模型,UI 问题用多模态模型,复杂功能开发用推理模型)切换模型,以优化工作流。

Chapter 2: LLM Benchmarks

主题:解释 LLM 基准测试,并将分数匹配到开发需求。

基准测试类似于标准化考试,提供一致的方法比较模型能力,但高分不保证模型在所有任务中表现优异。

不同基准测试不同方面:编码能力、领域知识或工具使用能力;理解这些区别有助于匹配基准到实际需求。

编码能力基准(如 SWE-Bench)测试真实世界软件工程挑战(使用 GitHub 问题),其表现可预测 Cline 中的实际表现(如修复错误),但需注意数据污染问题(SWE-Bench Verified 可缓解)。

互补编码基准(如 HumanEval、LiveCodeBench、BigCodeBench)各有侧重:HumanEval 测试函数级代码生成,LiveCodeBench 最小化数据污染,BigCodeBench 评估复杂多文件任务。

领域特定知识基准(如 MMLU、GPQA、AIME)测试学科专业知识(如生物、数学),匹配基准领域到应用领域(如金融软件优先经济学基准)是关键。

工具使用能力基准测试模型与外部工具(如 MCP)交互的能力(如正确格式化工具调用),这对依赖 Cline 的 MCP 集成的用户至关重要。

基准测试的局限性:仅反映受控条件下的能力,无法完全捕捉实际开发环境(如独特代码库和工作流),因此实验至关重要。

实用评估策略:结合基准分析和实践测试——先根据用例(如编码、领域任务或 MCP 集成)选择相关基准,再在真实环境中测试模型表现。

随着经验积累,用户会发展出超越基准的直觉(如模型如何处理代码风格),这与基准数据互补形成全面理解。

Chapter 3: Choosing LLM for Cline

主题:通过平衡速度、上下文、成本和灵活性,为 Cline 选择最佳 LLM。

基准分数与真实效果脱节,因为实际开发涉及复杂因素(如工具使用能力),因此选择模型需始于理解具体用例和需求。

推理速度(以每秒令牌数衡量)是关键因素:小模型(如“lite”或“mini”变体)速度快但可能牺牲推理深度;旗舰模型则更慢但更细致。

速度在交互式工作流(如快速调试或紧期限)中尤为重要,累积时间节省可显著提升生产力。

上下文窗口大小影响任务处理:大窗口(如分析大型代码库)需上下文工程技能;Cline 提供窗口大小和消耗的透明度。

成本管理需平衡性能与投资:用高级模型处理复杂决策,经济模型处理常规任务;Cline 的令牌成本透明度支持明智决策。

分层方法(如快速模型用于探索、中端模型用于开发、高级模型用于复杂问题)可优化成本。

Cline 的模型无关设计提供灵活性:用户可实验不同模型,并配置不同模型用于不同模式(如 Plan 模式用快速模型,Act 模式用能力模型)。

任务驱动方法:最佳模型是匹配具体目标(如速度、成本或质量优先级)和约束(如工具使用或上下文需求)的模型。

优化是迭代过程:通过实验(测试同一任务不同模型)和精炼,发展基于经验的模型选择策略。

目标不是找到单一“最佳”模型,而是开发战略方法以最大化整体生产力和效率。

Chapter 4: LLM Providers

主题:利用 Cline 的模型无关设计,通过提供者、聚合器或本地模型路由任务以优化成本、速度和隐私。

Cline 的模型无关哲学确保用户不被锁定于特定模型或提供商,支持基于任务切换模型、利用新模型、避免供应商锁定和优化优先级。

三种路由端点:直接连接提供商(如 Anthropic、OpenAI)、通过聚合器路由、本地模型(如 LM Studio)。

直接连接的优势:访问最新模型、无中介延迟、提供商特定功能;劣势:需管理多账户和 API 密钥。

聚合器作为通用路由器:提供单接口访问多提供商、信用系统试用模型、额外功能(如分析工具);私有托管选项吸引企业用户。

本地模型部署的优势:完全隐私、无持续成本(仅硬件)、完全控制;劣势:需硬件和技术投入,模型选择有限。

战略路由决策:混合方法(如敏感项目用本地模型,生产工作用直接连接,实验用聚合器)可优化不同优先级。

路由决策应基于任务类型:快速迭代用本地模型,复杂决策用提供商模型,常规任务用聚合器。

Cline 的设置界面简化路由管理:可配置多端点并切换,支持实验(如测试同一任务不同路由的成本和速度)。

路由选择超越技术考量,涵盖数据隐私、成本、供应商关系和操作灵活性等战略决策。

用户应评估优先级(如隐私 vs 性能)并实验路由选项,以找到最适合其工作流的策略。

要点总结 :

-

• 模型选择必须基于具体任务需求

-

• Cline 的模型无关设计提供灵活性和优化能力

-

• 平衡速度、成本、能力和上下文是关键权衡点

-

• 基准测试需结合实践实验

-

• 路由策略应匹配优先级

如何系统的去学习大模型LLM ?

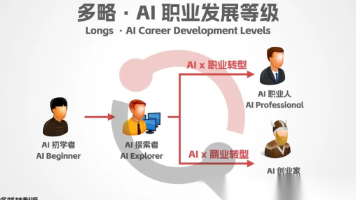

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等

😝有需要的小伙伴,可以 下方小卡片领取🆓↓↓↓

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)