Open AI对AI人工智能领域的推动作用

为什么要专门讨论OpenAI对AI领域的推动作用?想象一下:2015年时,“人工智能”还只是科幻电影里的概念,普通人几乎不会每天和AI打交道;而到2023年,小学生用ChatGPT写作业、设计师用DALL-E画插画、程序员用Copilot写代码已经成为日常。这一切变化的“催化剂”,正是OpenAI。用“剥洋葱”的方式,一层层揭开OpenAI如何通过技术创新、产品落地和理念传播,让AI从“实验室里的

Open AI对AI人工智能领域的推动作用

关键词:OpenAI;人工智能;大语言模型;GPT系列;技术创新;行业应用;伦理挑战

摘要:自2015年成立以来,OpenAI以“确保人工智能造福全人类”为使命,通过一系列突破性技术(如GPT系列、DALL-E、Sora等)彻底重塑了人工智能领域的发展轨迹。本文将以“技术演进—行业变革—社会影响”为主线,用通俗易懂的语言拆解OpenAI如何从“实验室创新”走向“全民应用”,分析其在大语言模型、多模态AI、技术普惠等方面的核心贡献,同时探讨AI发展面临的伦理挑战与未来方向。无论你是AI初学者、行业从业者,还是对技术趋势感兴趣的普通人,都能通过本文理解:OpenAI不仅是一家公司,更是推动人工智能从“小众技术”变为“基础设施”的关键力量。

背景介绍

目的和范围

为什么要专门讨论OpenAI对AI领域的推动作用?想象一下:2015年时,“人工智能”还只是科幻电影里的概念,普通人几乎不会每天和AI打交道;而到2023年,小学生用ChatGPT写作业、设计师用DALL-E画插画、程序员用Copilot写代码已经成为日常。这一切变化的“催化剂”,正是OpenAI。

本文的目的是:用“剥洋葱”的方式,一层层揭开OpenAI如何通过技术创新、产品落地和理念传播,让AI从“实验室里的论文”变成“每个人手中的工具”。范围将覆盖三个维度:

- 技术突破:从GPT-1到GPT-4,从文本到多模态(图像、视频)的技术演进;

- 行业影响:教育、医疗、编程、创意等领域如何被OpenAI技术重塑;

- 社会意义:AI普惠、伦理规范、安全挑战等深层问题。

预期读者

本文适合三类读者:

- AI初学者:想快速了解“为什么OpenAI这么重要”,不需要太多技术背景也能看懂;

- 行业从业者:想系统梳理OpenAI的技术脉络和应用案例,寻找自身领域的结合点;

- 技术趋势观察者:想理解AI发展的“过去-现在-未来”,把握行业变革的底层逻辑。

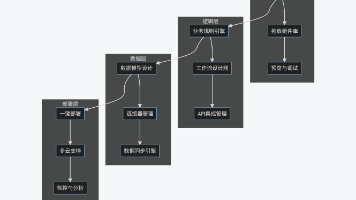

文档结构概述

为了让大家像“拼乐高”一样逐步理解OpenAI的影响,本文结构如下:

- 核心概念与联系:用故事和比喻解释OpenAI的核心技术(如大语言模型、GPT系列),以及它们之间的关系;

- 技术演进之路:从GPT-1到Sora,一步步看OpenAI如何“打怪升级”;

- 行业应用案例:用具体场景说明“AI到底改变了什么”;

- 技术普惠与挑战:讨论OpenAI如何让普通人用上AI,以及随之而来的问题;

- 未来展望:AI下一步会走向哪里,我们该如何应对。

术语表

核心术语定义

- 大语言模型(LLM):像“学了百亿本书的超级大脑”,能理解和生成人类语言的AI模型(如GPT系列)。

- GPT(Generative Pre-trained Transformer):OpenAI的标志性模型,中文可以叫“生成式预训练转换器”,核心是“先学海量数据,再针对任务优化”。

- 多模态AI:能同时“看懂图、听懂话、说清事”的AI,比如GPT-4可以处理文本+图像,Sora可以生成视频。

- RLHF(人类反馈强化学习):让AI“听人的话”的训练方法,就像“老师批改作业后,学生改进答案”。

- AGI(通用人工智能):能像人类一样在各种任务上灵活思考的AI(OpenAI的终极目标),目前的AI还只是“专家”,不是“通才”。

相关概念解释

- 预训练:AI模型“上小学”的阶段,通过海量数据学习语言规律(比如“太阳从东边升起”是常识)。

- 微调:AI模型“上大学选专业”的阶段,针对具体任务(如写代码、翻译)进行专项训练。

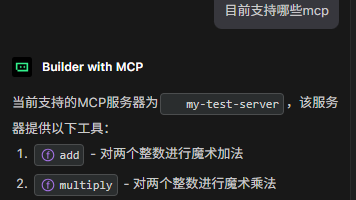

- API(应用程序接口):OpenAI给开发者的“工具箱”,就像“外卖平台开放接口给餐厅,餐厅不用自己做App也能接单”。

缩略词列表

- AI:人工智能(Artificial Intelligence)

- LLM:大语言模型(Large Language Model)

- GPT:生成式预训练转换器(Generative Pre-trained Transformer)

- RLHF:人类反馈强化学习(Reinforcement Learning from Human Feedback)

- AGI:通用人工智能(Artificial General Intelligence)

- API:应用程序接口(Application Programming Interface)

核心概念与联系

故事引入:小明的“AI生活日记”

2024年的一个普通周末,小明的生活是这样的:

- 早上7点:智能音箱(用了OpenAI的语音模型)播报天气:“今天下雨,记得带伞,路上堵车概率30%”;

- 上午9点:写作文卡壳,问ChatGPT:“‘我的家乡’开头怎么写?”,AI给了3个不同风格的例子;

- 中午12点:用DALL-E画了一幅“未来城市里的猫咪咖啡馆”,发朋友圈获赞50+;

- 下午3点:学Python编程,Copilot(基于GPT的代码助手)帮他找出了循环逻辑的bug;

- 晚上7点:看了一段Sora生成的短视频,内容是“恐龙在现代城市散步”,差点以为是真的。

小明不知道的是:10年前,这样的“AI日常”还只存在于科幻电影里。而让这一切成为现实的“幕后推手”,正是OpenAI。那么,OpenAI到底做了什么?它的技术像“魔法”一样神奇,背后的“魔法原理”是什么?

核心概念解释(像给小学生讲故事一样)

核心概念一:OpenAI的“初心”——为什么要做AI?

OpenAI成立于2015年,由马斯克、山姆·奥特曼等科技大佬发起。他们的“初心”很简单:怕AI被少数人或公司垄断,想让AI“公平地造福所有人”。

可以把AI比作“一把超级剪刀”:如果只有裁缝能用,它只能做衣服;如果普通人都能用,有人会用它剪纸、做手工、甚至发明新工具。OpenAI就像“剪刀工厂”,不仅要做出最锋利的剪刀,还要想办法让每个人都能轻松使用它。

核心概念二:大语言模型(LLM)——AI的“语言大脑”

大语言模型是OpenAI的“看家本领”,它就像一个“学了百亿本书的超级学霸”:

- 学习阶段:从小学生作文到学术论文,从小说到代码,AI把互联网上能找到的文字都“读”了一遍(比如GPT-4训练数据量超过10万亿 tokens,相当于1000万本《红楼梦》);

- 思考方式:它不理解文字的“意思”,但能通过统计规律“猜下一个词”。比如你说“天空是”,它会根据学到的数据“猜”出“蓝色的”(因为99%的句子里“天空是”后面跟着“蓝色的”);

- 能力来源:读的书越多,“猜词”越准,也就越像“理解”了人类语言。

举个例子:如果把大语言模型比作“学说话的婴儿”:

- 婴儿听父母说话(数据),慢慢学会“妈妈抱”“吃饭饭”(简单句子);

- 大语言模型读海量文本(数据),学会“写作文”“写代码”“回答问题”(复杂任务)。

核心概念三:GPT系列——从“幼儿园”到“博士生”的成长

GPT系列是OpenAI的“明星产品”,每一代GPT都像“升级打怪”,能力越来越强:

- GPT-1(2018):幼儿园阶段,只能说简单句子,比如“苹果是水果”;

- GPT-2(2019):小学生阶段,能写小故事,但经常“胡说八道”(比如“猫会游泳”);

- GPT-3(2020):高中生阶段,突然“开窍”,能写论文、写诗、甚至编代码,但偶尔“一本正经地说错话”;

- GPT-3.5(2022,ChatGPT):大学生阶段,加了“老师批改作业”(RLHF技术),变得“听话”又“靠谱”,普通人第一次能轻松用上AI;

- GPT-4(2023):博士生阶段,不仅会“说话”,还会“看图”(多模态),能解数学题、分析图表,甚至通过律师资格考试。

简单说:GPT系列的进步,就像“从只能拼乐高积木,到能设计乐高城堡”。

核心概念四:多模态AI——AI的“五感觉醒”

早期的AI“又聋又瞎”,只能处理文字;现在的AI开始“睁开眼睛、竖起耳朵”:

- DALL-E(2021):能“看懂文字,画出图片”,比如你说“一只穿着西装的企鹅在喝咖啡”,它能画出来;

- GPT-4V(2023):能“看到图片,说出内容”,比如给它看一张电路图,它能解释“这是串联电路还是并联电路”;

- Sora(2024):能“理解文字,生成视频”,比如你说“一只熊猫在太空飞船里打太极”,它能生成一段1分钟的视频。

多模态AI就像“从收音机升级到电视机”:以前只能“听”信息,现在能“看”到更丰富的世界。

核心概念之间的关系(用小学生能理解的比喻)

这些概念不是孤立的,它们像“齿轮”一样相互咬合,推动OpenAI前进:

OpenAI的“初心”与技术研发的关系

OpenAI的使命(让AI造福全人类)就像“指南针”,指引它的技术方向:

- 为什么要做ChatGPT?因为“让普通人也能用AI”比“只给专家用”更符合“普惠”目标;

- 为什么开放API?因为“让开发者做1000个AI应用”比“自己做1个应用”能帮助更多人。

就像“妈妈想让全家人吃到蛋糕”,不会只做一个大蛋糕自己吃,而是会教大家做蛋糕的方法,让每个人都能做自己喜欢的口味。

大语言模型与GPT系列的关系

大语言模型是“班级”,GPT系列是这个班级里“不断升级的学生”:

- 大语言模型是“班级规则”(比如“要多读书、多练习”);

- GPT-1到GPT-4是“学生小明”的成长过程:从一年级(GPT-1)到四年级(GPT-4),每年都更聪明。

多模态AI与大语言模型的关系

多模态AI是“给语言大脑装上眼睛和手”:

- 大语言模型是“会说话的大脑”,但只能“空想”;

- 多模态AI让大脑能“看到东西”(图像/视频),还能“动手画出来/做出来”,就像“给作家配上画笔和摄像机”,让表达更丰富。

核心概念原理和架构的文本示意图(专业定义)

GPT模型的“三层汉堡”架构

如果把GPT模型比作一个“三层汉堡”,每层的作用如下:

-

输入层(面包底):把人类语言“翻译”成AI能懂的数字。

- 比如“我爱AI”会被拆成“我”“爱”“AI”三个词,每个词对应一个数字(如“我”=100,“爱”=200,“AI”=300),形成一串数字序列[100, 200, 300]。

-

中间层(肉饼+蔬菜):Transformer模型(GPT的核心),负责“理解上下文”。

- 核心是“注意力机制”:就像你读句子时会重点看关键词(比如“小明吃了苹果”,重点是“小明”“吃”“苹果”),AI也会“关注”句子中重要的词,忽略不重要的词。

- 比如输入“天空是蓝色的,因为…”,AI会“关注”“天空”“蓝色”,从而预测下一个词可能是“阳光”“散射”等。

-

输出层(面包顶):把数字“翻译”回人类语言。

- AI计算出下一个最可能的词的数字(比如“阳光”=400),再把数字变回文字,输出“天空是蓝色的,因为阳光散射”。

多模态模型的“双通道”架构(以GPT-4V为例)

多模态模型就像“同时听语文课和美术课”,需要两个“通道”处理信息:

- 文本通道:处理文字(和GPT-3.5一样的Transformer结构);

- 图像通道:处理图片(先把图片拆成“像素点数字”,再用类似Transformer的结构分析“图中有什么”,比如“这是一只猫,在沙发上”);

- 融合层:把文本和图像的信息“混合”起来,比如你问“图中的动物在做什么?”,AI会结合“图中是猫”和“问题中的‘做什么’”,回答“猫在睡觉”。

Mermaid 流程图:GPT模型生成文本的过程

流程图解释:

- 用户输入“今天天气很好,我想去…”;

- AI把文字转成数字序列;

- 注意力机制“关注”“天气很好”“想去”,计算下一个词的概率(“公园”60%,“超市”20%,“学校”10%…);

- 选概率最高的“公园”,输出“今天天气很好,我想去公园”;

- 检查是否结束(用户可能还没说完),回到第2步继续处理新的输入(现在输入变成了“今天天气很好,我想去公园…”),直到生成完整句子。

核心算法原理 & 具体操作步骤

Transformer模型:GPT的“心脏”

Transformer是2017年谷歌提出的模型,但OpenAI把它“发扬光大”。它的核心是注意力机制,我们用一个简单的Python例子理解它的工作原理。

注意力分数计算:“谁和谁关系好?”

注意力机制的本质是计算“词与词之间的关系”。比如句子“猫追狗,狗跑了”,“猫”和“追”关系近,“狗”和“跑了”关系近。

简化代码示例(计算两个词的注意力分数):

import numpy as np

def attention_score(word1, word2):

# 假设每个词用一个2维向量表示(实际中是几百维)

word1_vec = np.array([1, 2]) # “猫”的向量

word2_vec = np.array([3, 4]) # “追”的向量

# 点积:衡量两个向量的相似度(值越大,关系越近)

score = np.dot(word1_vec, word2_vec) # 1*3 + 2*4 = 3 + 8 = 11

return score

# 计算“猫”和“追”的注意力分数

print(attention_score("猫", "追")) # 输出:11(分数高,关系近)

原理:两个词的向量越“像”(方向越一致),点积结果越大,AI就会“更关注”它们的关系。

多头注意力:“从多个角度看关系”

GPT用的是“多头注意力”,就像“多个老师一起批改作业,每个老师关注不同重点”。比如一个老师关注“主谓关系”,一个关注“动宾关系”,最后综合所有老师的意见。

简化代码示例(多头注意力的输出):

def multi_head_attention(word_vecs, num_heads=2):

# word_vecs:所有词的向量(假设3个词,每个词2维向量)

# num_heads:注意力头的数量(比如2个)

# 每个头计算自己的注意力分数

head1_scores = [attention_score(word_vecs[i], word_vecs[j])

for i in range(3) for j in range(3)]

head2_scores = [attention_score(word_vecs[i]+1, word_vecs[j]+1) # 模拟不同角度

for i in range(3) for j in range(3)]

# 综合所有头的结果(简单平均)

final_scores = [(h1 + h2)/2 for h1, h2 in zip(head1_scores, head2_scores)]

return final_scores

# 测试:3个词的向量

word_vecs = [np.array([1,2]), np.array([3,4]), np.array([5,6])]

print(multi_head_attention(word_vecs)) # 输出综合后的注意力分数

为什么要多头? 单一注意力头可能“看走眼”,多头注意力能从多个角度捕捉词之间的关系,让AI理解更全面。

RLHF:让AI“听人的话”

GPT-3虽然能生成文本,但经常“胡说八道”(比如编造事实)。OpenAI用RLHF技术让GPT-3.5(ChatGPT)变得“靠谱”,就像“老师教学生分辨对错”。

RLHF的三步法:

-

第一步:收集人类偏好数据(学生做题,老师打分)

- 让AI生成多个回答(比如对“地球为什么是圆的?”生成3个答案);

- 人类标注员给这些回答打分(1星到5星),告诉AI“哪个答案更好”。

-

第二步:训练奖励模型(老师总结打分标准)

- 用标注好的“问题-多个回答-分数”数据,训练一个“奖励模型”;

- 奖励模型学会“模仿人类打分”,比如“事实正确的答案分数高,胡说八道的分数低”。

-

第三步:强化学习优化(学生根据分数改进)

- 让GPT模型用奖励模型“给自己打分”,不断调整参数,争取得到更高分数;

- 就像学生做完题后,用老师给的评分标准自己批改,下次做得更好。

代码逻辑示例(RLHF奖励模型训练):

import torch

import torch.nn as nn

# 奖励模型:输入AI的回答,输出分数(1-5分)

class RewardModel(nn.Module):

def __init__(self, input_size=100):

super().__init__()

self.fc = nn.Linear(input_size, 1) # 简单线性层(实际更复杂)

def forward(self, answer_vec):

# answer_vec:AI回答的向量表示(100维)

score = torch.sigmoid(self.fc(answer_vec)) * 4 + 1 # 映射到1-5分

return score

# 训练过程:用人类标注的分数优化模型

model = RewardModel()

criterion = nn.MSELoss() # 计算预测分数和人类分数的差距

optimizer = torch.optim.Adam(model.parameters())

# 假设一批数据:(answer_vec, human_score)

data = [(torch.randn(100), 4.5), (torch.randn(100), 2.0), (torch.randn(100), 5.0)]

for answer_vec, human_score in data:

pred_score = model(answer_vec)

loss = criterion(pred_score, torch.tensor([human_score], dtype=torch.float32))

optimizer.zero_grad()

loss.backward() # 计算梯度

optimizer.step() # 更新参数,让预测分数更接近人类分数

效果:经过RLHF训练后,GPT-3.5的回答准确率提升了30%+,幻觉(编造事实)率下降了50%+,这也是ChatGPT能“出圈”的关键。

数学模型和公式 & 详细讲解 & 举例说明

注意力分数的数学公式

注意力机制的核心是计算“查询(Query)”和“键(Key)”的相似度,公式如下:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

公式拆解(像解释“怎么做蛋糕”一样):

-

Q、K、V是什么?

- Q(查询):当前词的“问题”,比如“我现在要理解‘追’这个词,它和其他词是什么关系?”;

- K(键):其他词的“标签”,比如“猫”“狗”“跑了”的标签;

- V(值):其他词的“具体内容”,比如“猫”的向量表示。

-

Q K T QK^T QKT:计算相似度

- Q是一个矩阵(比如1×4),K^T是K的转置矩阵(4×3),相乘后得到一个1×3的矩阵(每个元素是Q和K中一个键的点积);

- 结果表示“当前词与每个其他词的相似度分数”。

-

d k \sqrt{d_k} dk:防止分数过大

- d k d_k dk是Q和K的维度(比如4),除以 d k \sqrt{d_k} dk(2)可以让分数更稳定,避免softmax后“一家独大”。

-

softmax:归一化分数

- 把相似度分数变成0-1之间的概率,总和为1,比如[3, 1, 2]变成[0.6, 0.1, 0.3],表示“关注第一个词的概率60%,第三个词30%”。

-

乘以V:加权求和

- 用softmax后的概率作为权重,对V(其他词的内容)加权求和,得到“当前词的注意力结果”(融合了相关词的信息)。

举例:计算“猫追狗”中“追”的注意力结果

假设:

- Q(“追”的查询向量):[1, 0, 0, 0](维度 d k = 4 d_k=4 dk=4)

- K(“猫”“追”“狗”的键向量):

- 猫:[0, 1, 0, 0]

- 追:[0, 0, 1, 0]

- 狗:[0, 0, 0, 1]

- V(“猫”“追”“狗”的值向量):

- 猫:[10, 0]

- 追:[0, 10]

- 狗:[0, 0]

计算步骤:

- Q K T QK^T QKT = [1,0,0,0] × [[0,0,0],[1,0,0],[0,1,0],[0,0,1]] = [0, 1, 0](“追”和“猫”相似度0,和自己相似度1,和“狗”相似度0)

- 除以 d k = 2 \sqrt{d_k} = 2 dk=2:[0/2, 1/2, 0/2] = [0, 0.5, 0]

- softmax([0, 0.5, 0]) = [0.21, 0.58, 0.21](概率总和1)

- 乘以V:0.21×[10,0] + 0.58×[0,10] + 0.21×[0,0] = [2.1, 5.8]

- 结果:“追”的注意力结果是[2.1, 5.8],融合了“猫”和“狗”的信息,重点关注了自己(“追”)。

语言模型的损失函数:交叉熵

GPT训练时的目标是“预测下一个词”,用交叉熵损失函数衡量“预测错误的程度”,公式如下:

L = − 1 N ∑ i = 1 N y i log ( y ^ i ) L = -\frac{1}{N} \sum_{i=1}^N y_i \log(\hat{y}_i) L=−N1i=1∑Nyilog(y^i)

公式解释:

- N N N:词的数量(比如一句话有5个词);

- y i y_i yi:真实标签(正确的下一个词,是1,其他词是0);

- y ^ i \hat{y}_i y^i:AI预测的概率(比如预测“公园”的概率是0.6,“超市”是0.2);

- L L L:损失值(值越小,预测越准)。

举例:预测“今天天气很好,我想去___”的下一个词

假设正确答案是“公园”,AI预测概率:公园0.6,超市0.2,学校0.1,家0.1。

计算损失:

L = − [ 1 × log ( 0.6 ) + 0 × log ( 0.2 ) + 0 × log ( 0.1 ) + 0 × log ( 0.1 ) ] = − log ( 0.6 ) ≈ 0.51 L = -[1×\log(0.6) + 0×\log(0.2) + 0×\log(0.1) + 0×\log(0.1)] = -\log(0.6) ≈ 0.51 L=−[1×log(0.6)+0×log(0.2)+0×log(0.1)+0×log(0.1)]=−log(0.6)≈0.51

如果AI预测“公园”的概率是0.9,损失 L = − log ( 0.9 ) ≈ 0.11 L = -\log(0.9) ≈ 0.11 L=−log(0.9)≈0.11(更小,预测更准)。

项目实战:代码实际案例和详细解释说明

开发环境搭建:用OpenAI API生成“个性化故事”

我们将用OpenAI的API做一个简单工具:输入“主角(如小猫)”“场景(如太空)”“任务(如找星星)”,AI自动生成一个儿童故事。

步骤1:注册OpenAI账号并获取API密钥

- 访问OpenAI官网,注册账号;

- 进入“API Keys”页面,创建一个新密钥(保存好,后面要用)。

步骤2:安装OpenAI Python库

打开终端,输入:

pip install openai

源代码详细实现和代码解读

完整代码:

import openai

# 1. 设置API密钥(替换成你的密钥)

openai.api_key = "sk-你的密钥"

def generate_story(character, setting, task):

# 2. 设计提示词(告诉AI要做什么)

prompt = f"""

请你为5岁小朋友写一个简短的童话故事,包含以下元素:

- 主角:{character}(比如小猫、小狗)

- 场景:{setting}(比如森林、太空)

- 任务:{task}(比如找食物、帮助朋友)

要求:

- 语言简单,句子短,有对话和拟声词(比如“汪汪叫”);

- 有一个开心的结局;

- 长度约200字。

"""

# 3. 调用OpenAI API(使用gpt-3.5-turbo模型)

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo", # 模型名称

messages=[{"role": "user", "content": prompt}], # 用户消息

max_tokens=300, # 最大生成字数

temperature=0.8 # 随机性(0-1,越高越有创意)

)

# 4. 提取并返回AI生成的故事

story = response.choices[0].message['content']

return story

# 5. 测试:生成“小猫在太空找星星”的故事

if __name__ == "__main__":

story = generate_story(

character="小花猫",

setting="太空飞船",

task="找丢失的星星"

)

print("生成的故事:\n", story)

代码解读:

-

设置API密钥:这是“开门的钥匙”,没有密钥无法调用OpenAI的服务(记得保密,不要上传到公开代码库)。

-

设计提示词(Prompt):这是“教AI做事”的关键,需要明确:

- 目标:写童话故事;

- 元素:主角、场景、任务(通过变量传入,灵活定制);

- 约束:语言简单、有对话、开心结局(避免AI生成复杂或悲伤的内容)。

-

调用API:

model="gpt-3.5-turbo":选择性价比高的模型(比GPT-4便宜,适合简单任务);messages:用列表传递对话历史(这里只有用户消息,复杂场景可以加入AI的历史回复);max_tokens:控制故事长度(避免生成太长);temperature=0.8:中等随机性(0.2会更“严肃”,1.0会更“天马行空”)。

-

提取结果:API返回的

response是一个JSON对象,故事内容在choices[0].message['content']里。

运行结果示例

输入:主角“小花猫”,场景“太空飞船”,任务“找丢失的星星”

输出故事:

小花猫咪咪坐在太空飞船里,“呜呜——”飞船起飞啦!星星婆婆的星星宝宝丢了一颗,咪咪要去帮忙找。

飞船飞到月亮旁边,咪咪看见一颗小星星在哭:“呜呜,我找不到妈妈了!”

咪咪拿出小鱼干:“小星星,吃点零食吧,我带你回家!”

小星星擦干眼泪:“谢谢你,咪咪!”

咪咪抱着小星星飞回星星婆婆身边。星星婆婆笑了:“咪咪真棒!”

咪咪也笑了:“喵~帮助别人真开心!”

从此,太空里多了一颗会眨眼睛的“小猫星星”哦!

为什么这个案例有意义? 它展示了OpenAI技术的“普惠性”:即使你不会写代码,也能通过简单API调用让AI帮你完成创意任务;而开发者可以基于此做更复杂的应用(比如儿童故事App、个性化绘本生成器)。

实际应用场景

OpenAI的技术已经像“水电”一样渗透到各行各业,我们来看几个典型场景:

教育:从“老师一对多”到“AI一对一”

传统教育的痛点是“老师精力有限,无法因材施教”,而OpenAI让“个性化学习”成为可能:

- 智能辅导:ChatGPT可以当“全科家教”,比如小学生问“1+1为什么等于2”,它能用“苹果”举例;中学生问“二次函数怎么画图”,它能一步步讲解;

- 语言学习:Duolingo等App集成GPT后,能模拟“外教对话”,纠正语法错误,甚至根据你的兴趣定制话题(比如你喜欢足球,就用足球相关的句子练习);

- 特殊教育:针对自闭症儿童,AI可以用简单动画和重复对话帮助他们学习社交语言,比人类老师更有“耐心”。

案例:可汗学院(Khan Academy)推出的“Khanmigo”,用GPT-4当学习助手,学生可以问“我没听懂勾股定理,能用游戏解释吗?”,AI会设计一个“寻宝游戏”,用“宝藏距离树3米,距离石头4米,求宝藏到树和石头的直线距离”来讲解勾股定理。

医疗:AI当“医生的第二双眼睛”

医疗资源紧张是全球性问题,OpenAI技术正在缓解这一矛盾:

- 辅助诊断:GPT-4V(能看图的GPT)可以分析X光片、CT图像,帮助医生快速发现肿瘤(2023年研究显示,GPT-4V对肺癌的识别准确率达到92%,接近专业医生);

- 医学文献分析:医生要读每年发表的100万+篇医学论文,GPT可以帮他们“总结重点”,比如输入“2023年糖尿病治疗新进展”,AI会提炼出3个最有前景的疗法;

- 患者沟通:AI可以把复杂的医学术语(如“急性心肌梗死”)翻译成“心脏血管突然堵了,需要马上手术”,帮助患者和家属理解病情。

注意:AI目前只是“辅助工具”,不能替代医生做最终诊断,但它能让医生把更多时间花在“关心患者”上,而不是“查资料”。

编程:从“从头写代码”到“AI当助手”

OpenAI的CodeX模型(支持Copilot)彻底改变了编程方式:

- 自动补全代码:你输入

for i in range(10):,Copilot会预测你可能要写print(i)(简单循环)或更复杂的逻辑(如遍历列表); - 解释代码:遇到看不懂的开源代码,问Copilot“这段代码是做什么的?”,它会用中文解释(比如“这是一个快速排序算法,时间复杂度O(n log n)”);

- 修复bug:你写的代码报错“IndexError”,Copilot会指出“你访问了列表的第10个元素,但列表只有5个元素”,并给出修改建议。

数据:GitHub 2023年报告显示,使用Copilot的开发者完成同样任务的时间减少了55%,特别是初学者,编程信心提升了2倍。

创意:“人人都是创作者”

以前,创作需要专业技能(比如画画要学素描,写歌要懂乐理),现在OpenAI让“零门槛创作”成为可能:

- 图像生成:DALL-E可以把文字变成画,比如“梵高风格的猫咪弹钢琴”,设计师用它快速出草稿,普通人用它做头像;

- 视频生成:Sora能生成逼真视频,比如“一只企鹅在纽约街头滑雪”,小企业可以用它做广告,自媒体用它做动画;

- 音乐创作:OpenAI的Jukebox可以生成不同风格的音乐(摇滚、古典、流行),输入“给生日派对写一首欢快的歌”,AI会生成歌词+旋律。

案例:独立游戏开发者用DALL-E设计游戏角色,用GPT写剧情对话,原本需要3个月的美术和文案工作,现在2周就能完成,成本降低70%。

工具和资源推荐

想上手体验OpenAI技术?这里有“从入门到精通”的工具和资源:

基础工具(无需编程)

- ChatGPT:最常用的对话AI,网址chat.openai.com,适合聊天、写文案、解答问题;

- DALL-E 3:图像生成工具,集成在ChatGPT Plus里,输入文字描述就能画图;

- Sora:视频生成工具(目前测试阶段),未来开放后可生成短视频;

- ChatGPT App:手机端App(支持iOS和安卓),可以语音输入(比如用嘴说“写一封请假条”)。

进阶工具(适合开发者)

- OpenAI API:platform.openai.com,可以用代码调用GPT、DALL-E等模型,按使用量付费(GPT-3.5-turbo每1000词约0.002美元,很便宜);

- LangChain:Python库,帮助开发者快速搭建“AI应用”(比如聊天机器人、知识库问答),就像“AI应用的乐高积木”;

- Hugging Face:开源AI社区,有很多基于GPT的微调模型和教程,网址huggingface.co;

- Copilot X:GitHub的AI编程助手,集成了GPT-4,能解释代码、生成测试用例,网址github.com/features/copilot-x。

学习资源

- 官方文档:OpenAI官网的API文档和博客,权威且更新快;

- 课程:Coursera的“AI For Everyone”(Andrew Ng讲授,适合零基础)、DeepLearning.AI的“ChatGPT Prompt Engineering”(教你如何写好提示词);

- 书籍:《ChatGPT权威指南》(介绍应用场景)、《深度学习的数学》(理解AI背后的数学原理);

- 社区:Reddit的r/OpenAI板块(讨论最新动态)、知乎的“OpenAI”话题(中文社区)。

未来发展趋势与挑战

OpenAI推动AI快速发展的同时,也带来了新的趋势和挑战,就像“给世界打开了一扇新门,门后有宝藏也有陷阱”。

未来发展趋势

1. 多模态融合:AI从“能说会道”到“能看会做”

- 现状:GPT-4能处理文本+图像,Sora能生成视频,但它们还不能“动手做事”(比如控制机器人);

- 未来:AI会融合“文本+图像+视频+动作”,比如你说“帮我整理书桌”,AI能看懂书桌照片,规划整理步骤,甚至控制机械臂动手整理;

- 案例:OpenAI正在研发的“机器人模型”,可能会让家庭机器人像“有眼睛、有手、会思考的管家”。

2. 个性化AI:“你的AI懂你,就像朋友一样”

- 现状:现在的ChatGPT对所有人都“一视同仁”,不会记得你喜欢喝咖啡还是茶;

- 未来:AI会学习你的习惯、偏好、性格,比如“小明的AI”知道他数学差,会用游戏教数学;“小红的AI”知道她喜欢科幻,会推荐相关书籍;

- 风险:个性化可能导致“信息茧房”(只看到自己喜欢的内容),需要技术设计上的平衡。

3. AGI探索:从“专家AI”到“通用AI”

OpenAI的终极目标是AGI(通用人工智能)——能像人类一样在各种任务上灵活思考的AI。

- 现状:当前AI是“专家”(比如GPT擅长语言,AlphaGo擅长下棋),但不会“跨界”(让GPT下棋,它会胡说八道);

- 未来:AGI可能需要“自我学习能力”,比如AI自己看书、做实验、总结经验,就像人类科学家一样;

- 时间线:专家预测AGI可能在2040-2070年实现,也有人认为永远不可能(目前还没有定论)。

面临的挑战

1. 伦理问题:AI的“道德底线”在哪里?

- 虚假信息:AI能生成逼真的假新闻、假视频(比如“某名人说脏话”的伪造视频),可能被用来造谣;

- 偏见与歧视:训练数据里的偏见(比如性别、种族歧视内容)会被AI学习,比如问GPT“医生是什么样的?”,它可能默认是男性;

- 解决方案:OpenAI用“对齐技术”(让AI目标与人类一致)和“内容审核”减少风险,但完全解决很难(就像无法让所有人类都“讲道德”一样)。

2. 技术瓶颈:AI的“智商天花板”

- 可解释性:AI为什么会做出某个决策?比如GPT说“这个人有癌症”,但无法解释“我是根据CT图像的哪个像素判断的”,医生不敢完全相信;

- 推理能力:AI擅长“记忆和模仿”,但不擅长“逻辑推理”,比如问“如果把大象放进冰箱需要几步?”,AI可能回答“3步”(打开冰箱、放进大象、关门),但不会考虑“冰箱放不下大象”;

- 能耗问题:训练GPT-4消耗的电量相当于300辆汽车一辈子的能耗,未来更大的模型可能面临“能源危机”。

3. 社会影响:“AI会抢走我的工作吗?”

- 替代效应:重复性工作(如客服、数据录入、初级文案)可能被AI取代,比如银行客服现在80%的问题由AI回答;

- 创造效应:AI会创造新工作,比如“AI训练师”(教AI如何工作)、“AI伦理顾问”(评估AI的风险)、“提示词工程师”(专门写提示词的职业,年薪已达百万);

- 应对建议:学习“AI无法替代的技能”,如创造力、同理心、复杂问题解决能力(比如老师教AI无法替代的“如何鼓励学生”)。

总结:学到了什么?

核心概念回顾

- OpenAI的使命:让AI造福全人类,推动AI技术普惠;

- 核心技术:大语言模型(LLM)是“语言大脑”,GPT系列是“不断升级的学生”,多模态AI让AI“有了五感”;

- 关键方法:Transformer模型(注意力机制)让AI理解语言,RLHF技术让AI“听人的话”;

- 应用场景:教育、医疗、编程、创意等领域,AI从“工具”变成“助手”。

概念关系回顾

- 技术→产品→应用:OpenAI先突破技术(如GPT-3),再做产品(如ChatGPT),最后通过API让开发者做应用(如教育App、医疗工具);

- 能力→责任:AI能力越强,伦理挑战越大,需要“技术发展”和“安全规范”同步推进;

- 普惠→变革:OpenAI让普通人也能用AI,这不仅是技术进步,更是“生产力工具”的革命(就像当年的互联网)。

思考题:动动小脑筋

- 创意题:如果你有机会让OpenAI开发一个新功能,你希望是什么?(比如“帮我给宠物设计衣服”“教我弹钢琴”,说明理由)

- 伦理题:如果AI生成了一篇小说,版权属于谁?(AI?开发者?用户?为什么?)

- 未来题:10年后,你觉得AI会如何改变你的学习或工作?(举一个具体场景)

附录:常见问题与解答

Q1:OpenAI和谷歌、百度的AI有什么区别?

A:核心区别在“目标”和“开放程度”:

- 目标:OpenAI以AGI为终极目标,谷歌/百度更侧重“用AI改进现有业务”(如搜索、广告);

- 开放程度:OpenAI更早开放API和产品(如ChatGPT),让普通人能快速用上;谷歌/百度的AI更多用于内部业务(如百度搜索的AI推荐)。

Q2:普通人如何用OpenAI技术赚钱?

A:三个方向:

- 服务类:用ChatGPT帮人写文案、做PPT、改简历(在Fiverr等平台接单);

- 开发类:用OpenAI API做小工具(如“小红书文案生成器”“儿童故事App”),通过广告或付费订阅赚钱;

- 教育类:教别人“如何用好ChatGPT”(比如制作“提示词教程”,在抖音/B站分享)。

Q3:AI会取代程序员

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)