AI智能编程工具汇总

命令行工具,用于调用 Gemini 系列大模型(如 Gemini 1.5),支持本地与 API 调用,适用于代码生成、文本处理等任务。

AI智能编程工具汇总

以下是一份关于主流大模型开发工具的综合介绍,涵盖 Gemini CLI、Qwen-Code、Kimi K2 等关键工具的功能特性、安装方式与使用建议。

🌟 Gemini CLI

开发者:Google DeepMind

简介:命令行工具,用于调用 Gemini 系列大模型(如 Gemini 1.5),支持本地与 API 调用,适用于代码生成、文本处理等任务。

功能特性

- 支持多模态输入(文本 / 图像)

- 上下文长度可扩展至百万 tokens

- 提供 Python SDK,便于集成开发

安装方式

npx https://github.com/google-gemini/gemini-cli

📌 需提前配置 Google API 密钥。

安装方式

💻 Qwen-Code

开发者:通义千问团队(Alibaba Cloud)

Qwen3-Coder开源:面向世界的智能编程引擎

简介:专为代码场景优化的大模型,支持 Python、C++ 等多种编程语言的生成、补全与理解。

功能亮点

支持 GitHub 仓库级代码理解

提供 IDE 插件(VS Code / JetBrains)

开放微调工具链,支持定制化训练

部署方式

- 安装nodejs/npx

wget https://nodejs.org/dist/v22.18.0/node-v22.18.0-linux-x64.tar.xz

tar xvf node-v22.18.0-linux-x64.tar.xz

vi .bashrc

export PATH=$PATH:/home/test/node-v22.18.0-linux-x64/bin

- 命令行工具安装

npm install -g @qwen-code/qwen-code

qwen --version

qwen

# update npx

npm install -g npm@11.5.2

-

国内用户免费每天2000次调用,不是2000 token哦

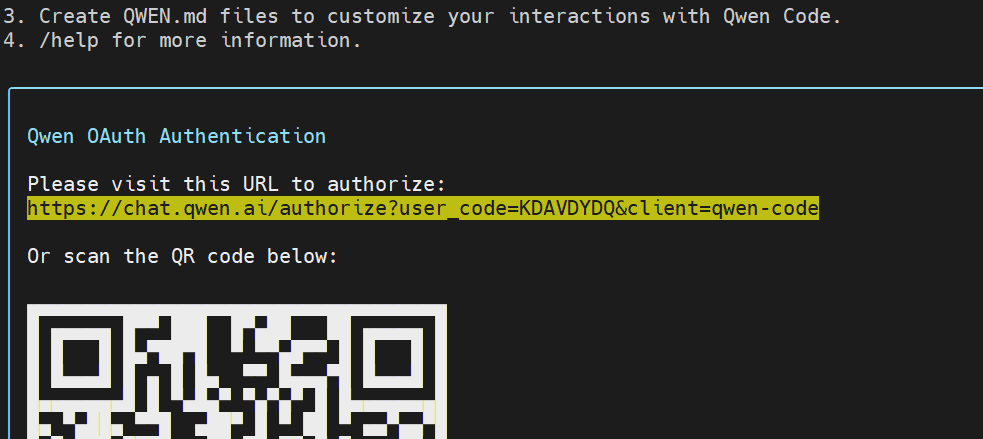

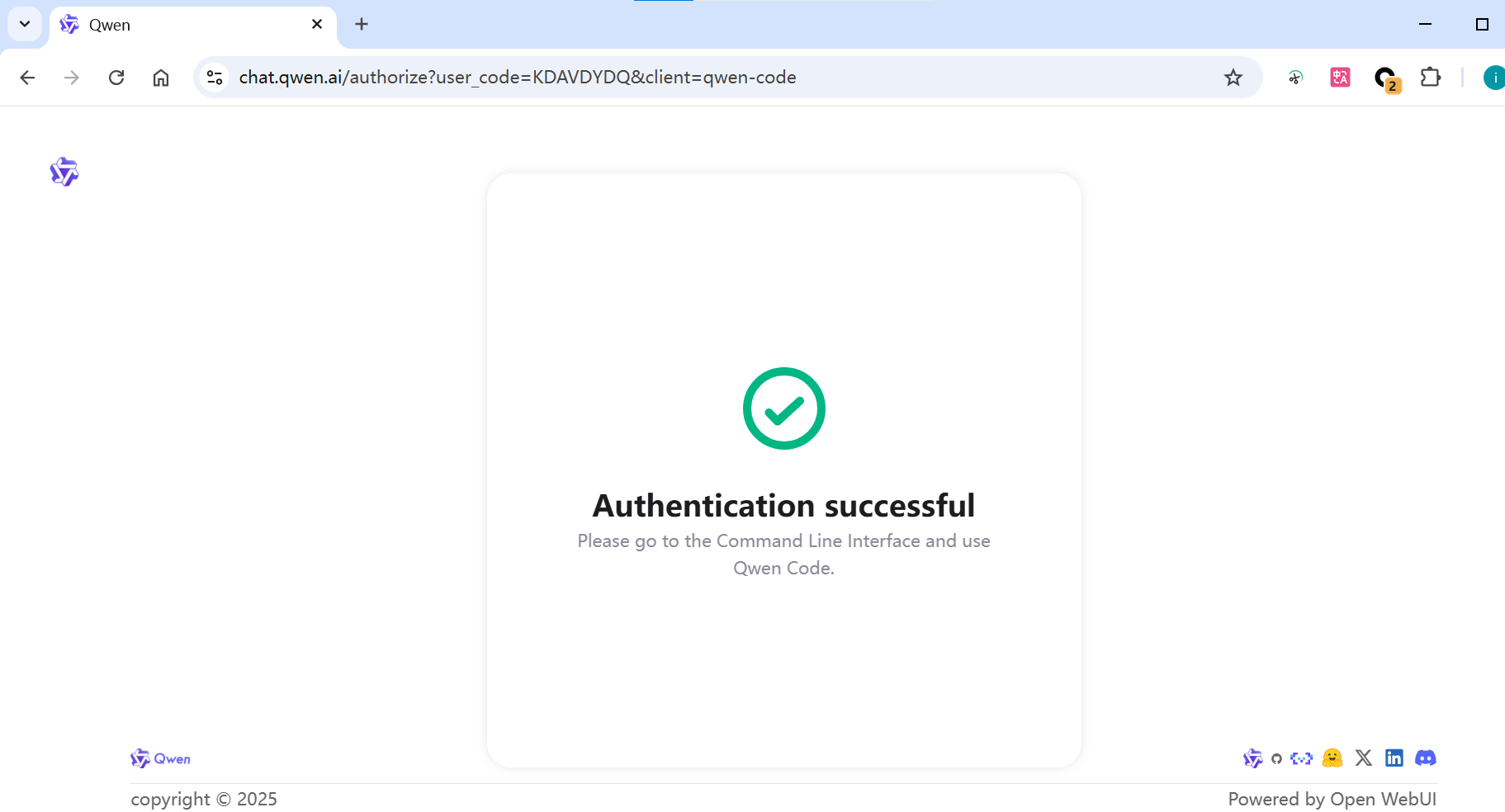

qwen启动后选择1:

1.qwen oauth

2.openai

https://chat.qwen.ai/authorize?user_code=XXXX&client=qwen-code

-

配置 API 访问(无效,暂时保留)(通过百炼平台)

模型->密钥管理

# 创建项目

mkdir myprj && cd myprj

# 配置环境变量

echo 'export OPENAI_API_KEY="sk-xxxx"' >> .env # 替换为百炼控制台获取的 API-KEY

echo 'export OPENAI_BASE_URL="https://dashscope.aliyuncs.com/compatible-mode/v1"' >> .env

echo 'export OPENAI_MODEL="qwen3-coder-480b-a35b-instruct"' >> .env

# 可选:echo 'export OPENAI_MODEL="qwen3-coder-plus"' >> .env

# 激活环境

source .env

📄 Kimi K2

开发者:月之暗面(Moonshot AI)

简介:Kimi Chat 的开发者版本,支持超长上下文(最高 200K tokens),擅长复杂逻辑推理与文档解析。

核心能力

支持 PDF、Word 等文档解析

提供 API 自动化能力

中文场景下表现优异,语义理解精准

访问方式

官网申请内测权限(Web 界面 + API)

支持通过 curl 调用 API

示例:使用 curl 调用 Kimi K2

curl -X POST https://api.moonshot.cn/v1/chat \

-H "Authorization: Bearer $API_KEY" \

-d '{

"model": "kimi-2",

"messages": [

{

"role": "user",

"content": "请解释 Transformer 架构的工作原理"

}

]

}'

🚀 Trae CN v2.0.4 正式发布

新增支持模型:

✅ Kimi-K2

✅ Qwen3-Coder

📌 选择建议

使用场景 推荐工具 说明

轻量级开发 / 快速原型 Gemini CLI 易上手,适合快速验证想法

代码专项任务 Qwen-Code 代码生成、补全、理解能力突出

长文本 / 文档分析 Kimi K2 200K 上下文窗口,适合处理大文档

⚠️ 注意:部分工具需申请 API 权限或具备特定硬件环境(如高显存 GPU),建议参考官方文档获取最新配置要求。

Tencent CloudBase AI ToolKit

https://github.com/TencentCloudBase/CloudBase-AI-ToolKit

grok cli

https://github.com/superagent-ai/grok-cli

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)