AI 驱动的软件开发新范式

本文探讨了人工智能在软件开发中的三大核心应用领域:自动化代码生成、低代码/无代码开发和算法优化实践。文章系统介绍了AI代码生成的技术原理与主流工具,展示了如何通过自然语言描述生成完整功能模块;深入分析了低代码平台与AI的融合架构,以及AI如何增强可视化开发能力;详细阐述了AI驱动的算法优化方法,包括性能评估指标和实际优化案例。同时,文章也指出了AI编程面临的安全性、知识产权和过度依赖等挑战,并提出

随着人工智能技术的飞速发展,软件开发领域正在经历一场深刻的变革。AI 编程工具不再是简单的代码补全助手,而已进化为能够理解复杂需求、生成完整功能模块、优化现有代码并提供开发全流程支持的智能伙伴。本文将系统探讨 AI 编程的三个核心领域 —— 自动化代码生成、低代码 / 无代码开发和算法优化实践,通过丰富的代码示例、流程图解和实践指南,为开发者提供一套全面的 AI 编程应用框架。

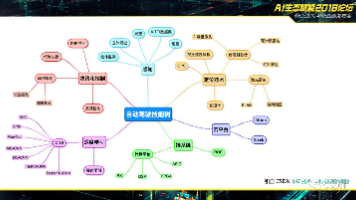

一、自动化代码生成:从自然语言到可执行代码

自动化代码生成是 AI 编程最引人注目的应用领域,它能够将自然语言描述的需求直接转换为可运行的代码,大幅提升开发效率并降低入门门槛。

1.1 代码生成的技术原理与流程

代码生成系统通常由四个核心模块构成:需求解析器、领域模型库、代码生成引擎和代码优化器。其工作流程如下:

graph TD

A[自然语言需求] --> B{需求解析器}

B --> C[意图识别]

B --> D[实体提取]

B --> E[约束条件分析]

C --> F{领域模型库}

D --> F

E --> F

F --> G{代码生成引擎}

G --> H[抽象语法树构建]

H --> I[代码片段生成]

I --> J[代码组装]

J --> K{代码优化器}

K --> L[语法检查]

K --> M[风格统一]

K --> N[性能优化]

L --> O[可执行代码]

M --> O

N --> O

1.2 实用代码生成工具与框架

1.2.1 OpenAI Codex 与 GPT-4 的代码生成实践

OpenAI 的 Codex 模型及其继承者 GPT-4 在代码生成领域表现卓越。以下是一个使用 GPT-4 生成数据处理模块的实例:

import pandas as pd

import numpy as np

from typing import Dict, List, Optional, Union

import logging

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

logger = logging.getLogger(__name__)

class DataProcessor:

"""

数据处理通用类,提供数据清洗、转换和基本分析功能

"""

def __init__(self, data: Optional[pd.DataFrame] = None):

"""

初始化数据处理器

Args:

data: 可选的初始DataFrame数据

"""

self.data = data

self.columns_info = self._get_columns_info() if data is not None else None

def load_data(self, file_path: str, file_type: str = 'csv', **kwargs) -> None:

"""

从文件加载数据

Args:

file_path: 数据文件路径

file_type: 文件类型,支持'csv'、'excel'、'json'

**kwargs: 传递给相应读取函数的参数

"""

try:

if file_type == 'csv':

self.data = pd.read_csv(file_path,** kwargs)

elif file_type == 'excel':

self.data = pd.read_excel(file_path, **kwargs)

elif file_type == 'json':

self.data = pd.read_json(file_path,** kwargs)

else:

raise ValueError(f"不支持的文件类型: {file_type}")

self.columns_info = self._get_columns_info()

logger.info(f"成功加载数据,形状: {self.data.shape}")

except Exception as e:

logger.error(f"加载数据失败: {str(e)}")

raise

def _get_columns_info(self) -> Dict[str, str]:

"""获取列名及其数据类型信息"""

return {col: str(dtype) for col, dtype in self.data.dtypes.items()}

def show_info(self) -> None:

"""显示数据集基本信息"""

if self.data is None:

logger.warning("没有加载数据")

return

print("数据集形状:", self.data.shape)

print("\n列信息:")

for col, dtype in self.columns_info.items():

print(f" {col}: {dtype}")

print("\n前5行数据:")

print(self.data.head())

def handle_missing_values(self, strategy: Dict[str, Union[str, float]] = None) -> None:

"""

处理缺失值

Args:

strategy: 每列的缺失值处理策略,格式为{列名: 策略}

策略可以是' drop'(删除行)、'mean'(均值填充)、'median'(中位数填充)

或具体数值

"""

if self.data is None:

logger.warning("没有加载数据")

return

if strategy is None:

logger.info("未指定处理策略,使用默认策略:删除全为空的行和列")

self.data.dropna(axis=0, how='all', inplace=True)

self.data.dropna(axis=1, how='all', inplace=True)

return

for column, method in strategy.items():

if column not in self.data.columns:

logger.warning(f"列 {column} 不存在,跳过")

continue

missing_count = self.data[column].isna().sum()

if missing_count == 0:

logger.info(f"列 {column} 没有缺失值,无需处理")

continue

logger.info(f"处理列 {column} 的 {missing_count} 个缺失值,使用策略: {method}")

if method == 'drop':

self.data.dropna(subset=[column], inplace=True)

elif method == 'mean':

if np.issubdtype(self.data[column].dtype, np.number):

fill_value = self.data[column].mean()

self.data[column].fillna(fill_value, inplace=True)

else:

logger.warning(f"列 {column} 不是数值类型,无法使用均值填充,已跳过")

elif method == 'median':

if np.issubdtype(self.data[column].dtype, np.number):

fill_value = self.data[column].median()

self.data[column].fillna(fill_value, inplace=True)

else:

logger.warning(f"列 {column} 不是数值类型,无法使用中位数填充,已跳过")

else:

# 使用指定值填充

self.data[column].fillna(method, inplace=True)

def convert_datatypes(self, conversions: Dict[str, str]) -> None:

"""

转换列的数据类型

Args:

conversions: 转换规则,格式为{列名: 目标类型}

支持的类型: 'int', 'float', 'str', 'datetime'

"""

if self.data is None:

logger.warning("没有加载数据")

return

for column, target_type in conversions.items():

if column not in self.data.columns:

logger.warning(f"列 {column} 不存在,跳过")

continue

try:

if target_type == 'int':

self.data[column] = self.data[column].astype(int)

elif target_type == 'float':

self.data[column] = self.data[column].astype(float)

elif target_type == 'str':

self.data[column] = self.data[column].astype(str)

elif target_type == 'datetime':

self.data[column] = pd.to_datetime(self.data[column])

else:

logger.warning(f"不支持的目标类型: {target_type},跳过列 {column}")

continue

logger.info(f"列 {column} 已转换为 {target_type} 类型")

except Exception as e:

logger.error(f"转换列 {column} 到 {target_type} 失败: {str(e)}")

def remove_duplicates(self, subset: Optional[List[str]] = None) -> None:

"""

移除重复行

Args:

subset: 用于判断重复的列列表,None表示使用所有列

"""

if self.data is None:

logger.warning("没有加载数据")

return

initial_count = len(self.data)

self.data.drop_duplicates(subset=subset, keep='first', inplace=True)

final_count = len(self.data)

removed_count = initial_count - final_count

if removed_count > 0:

logger.info(f"已移除 {removed_count} 个重复行")

else:

logger.info("没有发现重复行")

def basic_statistics(self, numeric_only: bool = True) -> pd.DataFrame:

"""

计算数据集的基本统计量

Args:

numeric_only: 是否只对数值列计算统计量

Returns:

包含统计信息的DataFrame

"""

if self.data is None:

logger.warning("没有加载数据")

return pd.DataFrame()

return self.data.describe(include='all' if not numeric_only else None)

def save_data(self, file_path: str, file_type: str = 'csv',** kwargs) -> None:

"""

保存处理后的数据

Args:

file_path: 保存路径

file_type: 文件类型,支持'csv'、'excel'、'json'

**kwargs: 传递给相应保存函数的参数

"""

if self.data is None:

logger.warning("没有数据可保存")

return

try:

if file_type == 'csv':

self.data.to_csv(file_path,** kwargs)

elif file_type == 'excel':

self.data.to_excel(file_path, **kwargs)

elif file_type == 'json':

self.data.to_json(file_path,** kwargs)

else:

raise ValueError(f"不支持的文件类型: {file_type}")

logger.info(f"数据已成功保存到 {file_path}")

except Exception as e:

logger.error(f"保存数据失败: {str(e)}")

raise

# 示例用法

if __name__ == "__main__":

# 创建数据处理器实例

processor = DataProcessor()

try:

# 加载数据

processor.load_data('sample_data.csv')

# 显示数据信息

processor.show_info()

# 处理缺失值

missing_strategy = {

'age': 'median',

'income': 'mean',

'occupation': 'Unknown'

}

processor.handle_missing_values(missing_strategy)

# 转换数据类型

type_conversions = {

'age': 'int',

'income': 'float',

'join_date': 'datetime'

}

processor.convert_datatypes(type_conversions)

# 移除重复行

processor.remove_duplicates(subset=['id', 'name'])

# 显示统计信息

stats = processor.basic_statistics()

print("\n数据统计信息:")

print(stats)

# 保存处理后的数据

processor.save_data('processed_data.csv', index=False)

except Exception as e:

logger.error(f"处理过程中发生错误: {str(e)}")

生成这段代码的 Prompt 示例:

plaintext

请创建一个Python数据处理类,具备以下功能:

1. 支持加载CSV、Excel和JSON格式的数据

2. 能够处理缺失值,提供多种填充策略

3. 可以转换列的数据类型

4. 能够移除重复行

5. 提供基本的统计分析功能

6. 支持将处理后的数据保存为多种格式

要求:

- 代码需要有完善的类型注解

- 包含详细的文档字符串

- 实现适当的错误处理

- 添加日志记录功能

- 提供示例用法

1.2.2 基于 Hugging Face Transformers 的代码生成

Hugging Face 提供了多种开源代码生成模型,如 CodeParrot、CodeT5 等,可用于本地化部署。

使用Hugging Face模型进行代码生成

import pandas as pd

import numpy as np

from typing import Dict, List, Optional, Union

import logging

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

logger = logging.getLogger(__name__)

class DataProcessor:

"""

数据处理通用类,提供数据清洗、转换和基本分析功能

"""

def __init__(self, data: Optional[pd.DataFrame] = None):

"""

初始化数据处理器

Args:

data: 可选的初始DataFrame数据

"""

self.data = data

self.columns_info = self._get_columns_info() if data is not None else None

def load_data(self, file_path: str, file_type: str = 'csv', **kwargs) -> None:

"""

从文件加载数据

Args:

file_path: 数据文件路径

file_type: 文件类型,支持'csv'、'excel'、'json'

**kwargs: 传递给相应读取函数的参数

"""

try:

if file_type == 'csv':

self.data = pd.read_csv(file_path,** kwargs)

elif file_type == 'excel':

self.data = pd.read_excel(file_path, **kwargs)

elif file_type == 'json':

self.data = pd.read_json(file_path,** kwargs)

else:

raise ValueError(f"不支持的文件类型: {file_type}")

self.columns_info = self._get_columns_info()

logger.info(f"成功加载数据,形状: {self.data.shape}")

except Exception as e:

logger.error(f"加载数据失败: {str(e)}")

raise

def _get_columns_info(self) -> Dict[str, str]:

"""获取列名及其数据类型信息"""

return {col: str(dtype) for col, dtype in self.data.dtypes.items()}

def show_info(self) -> None:

"""显示数据集基本信息"""

if self.data is None:

logger.warning("没有加载数据")

return

print("数据集形状:", self.data.shape)

print("\n列信息:")

for col, dtype in self.columns_info.items():

print(f" {col}: {dtype}")

print("\n前5行数据:")

print(self.data.head())

def handle_missing_values(self, strategy: Dict[str, Union[str, float]] = None) -> None:

"""

处理缺失值

Args:

strategy: 每列的缺失值处理策略,格式为{列名: 策略}

策略可以是' drop'(删除行)、'mean'(均值填充)、'median'(中位数填充)

或具体数值

"""

if self.data is None:

logger.warning("没有加载数据")

return

if strategy is None:

logger.info("未指定处理策略,使用默认策略:删除全为空的行和列")

self.data.dropna(axis=0, how='all', inplace=True)

self.data.dropna(axis=1, how='all', inplace=True)

return

for column, method in strategy.items():

if column not in self.data.columns:

logger.warning(f"列 {column} 不存在,跳过")

continue

missing_count = self.data[column].isna().sum()

if missing_count == 0:

logger.info(f"列 {column} 没有缺失值,无需处理")

continue

logger.info(f"处理列 {column} 的 {missing_count} 个缺失值,使用策略: {method}")

if method == 'drop':

self.data.dropna(subset=[column], inplace=True)

elif method == 'mean':

if np.issubdtype(self.data[column].dtype, np.number):

fill_value = self.data[column].mean()

self.data[column].fillna(fill_value, inplace=True)

else:

logger.warning(f"列 {column} 不是数值类型,无法使用均值填充,已跳过")

elif method == 'median':

if np.issubdtype(self.data[column].dtype, np.number):

fill_value = self.data[column].median()

self.data[column].fillna(fill_value, inplace=True)

else:

logger.warning(f"列 {column} 不是数值类型,无法使用中位数填充,已跳过")

else:

# 使用指定值填充

self.data[column].fillna(method, inplace=True)

def convert_datatypes(self, conversions: Dict[str, str]) -> None:

"""

转换列的数据类型

Args:

conversions: 转换规则,格式为{列名: 目标类型}

支持的类型: 'int', 'float', 'str', 'datetime'

"""

if self.data is None:

logger.warning("没有加载数据")

return

for column, target_type in conversions.items():

if column not in self.data.columns:

logger.warning(f"列 {column} 不存在,跳过")

continue

try:

if target_type == 'int':

self.data[column] = self.data[column].astype(int)

elif target_type == 'float':

self.data[column] = self.data[column].astype(float)

elif target_type == 'str':

self.data[column] = self.data[column].astype(str)

elif target_type == 'datetime':

self.data[column] = pd.to_datetime(self.data[column])

else:

logger.warning(f"不支持的目标类型: {target_type},跳过列 {column}")

continue

logger.info(f"列 {column} 已转换为 {target_type} 类型")

except Exception as e:

logger.error(f"转换列 {column} 到 {target_type} 失败: {str(e)}")

def remove_duplicates(self, subset: Optional[List[str]] = None) -> None:

"""

移除重复行

Args:

subset: 用于判断重复的列列表,None表示使用所有列

"""

if self.data is None:

logger.warning("没有加载数据")

return

initial_count = len(self.data)

self.data.drop_duplicates(subset=subset, keep='first', inplace=True)

final_count = len(self.data)

removed_count = initial_count - final_count

if removed_count > 0:

logger.info(f"已移除 {removed_count} 个重复行")

else:

logger.info("没有发现重复行")

def basic_statistics(self, numeric_only: bool = True) -> pd.DataFrame:

"""

计算数据集的基本统计量

Args:

numeric_only: 是否只对数值列计算统计量

Returns:

包含统计信息的DataFrame

"""

if self.data is None:

logger.warning("没有加载数据")

return pd.DataFrame()

return self.data.describe(include='all' if not numeric_only else None)

def save_data(self, file_path: str, file_type: str = 'csv',** kwargs) -> None:

"""

保存处理后的数据

Args:

file_path: 保存路径

file_type: 文件类型,支持'csv'、'excel'、'json'

**kwargs: 传递给相应保存函数的参数

"""

if self.data is None:

logger.warning("没有数据可保存")

return

try:

if file_type == 'csv':

self.data.to_csv(file_path,** kwargs)

elif file_type == 'excel':

self.data.to_excel(file_path, **kwargs)

elif file_type == 'json':

self.data.to_json(file_path,** kwargs)

else:

raise ValueError(f"不支持的文件类型: {file_type}")

logger.info(f"数据已成功保存到 {file_path}")

except Exception as e:

logger.error(f"保存数据失败: {str(e)}")

raise

# 示例用法

if __name__ == "__main__":

# 创建数据处理器实例

processor = DataProcessor()

try:

# 加载数据

processor.load_data('sample_data.csv')

# 显示数据信息

processor.show_info()

# 处理缺失值

missing_strategy = {

'age': 'median',

'income': 'mean',

'occupation': 'Unknown'

}

processor.handle_missing_values(missing_strategy)

# 转换数据类型

type_conversions = {

'age': 'int',

'income': 'float',

'join_date': 'datetime'

}

processor.convert_datatypes(type_conversions)

# 移除重复行

processor.remove_duplicates(subset=['id', 'name'])

# 显示统计信息

stats = processor.basic_statistics()

print("\n数据统计信息:")

print(stats)

# 保存处理后的数据

processor.save_data('processed_data.csv', index=False)

except Exception as e:

logger.error(f"处理过程中发生错误: {str(e)}")

1.3 代码生成的最佳实践与提示工程

要获得高质量的 AI 生成代码,需要掌握提示工程 (Prompt Engineering) 技巧:

- 明确具体需求:避免模糊表述,提供详细的功能描述和约束条件

- 指定技术栈:明确编程语言、框架版本和关键库

- 提供上下文:说明代码的应用场景和与其他模块的关系

- 设定代码质量要求:如注释、错误处理、测试等

- 使用示例驱动:提供输入输出示例或伪代码

优秀提示示例:

plaintext

请使用Python 3.9和FastAPI 0.95.0创建一个用户认证API端点,需实现以下功能:

1. 用户登录:接收用户名和密码,验证成功后返回JWT令牌

2. 令牌刷新:允许使用刷新令牌获取新的访问令牌

3. 密码重置请求:发送包含重置链接的邮件

4. 密码重置确认:验证重置令牌并更新密码

技术要求:

- 使用Pydantic进行数据验证,定义所有必要的模型

- 密码存储使用bcrypt加密

- JWT令牌有效期:访问令牌15分钟,刷新令牌7天

- 实现请求速率限制,防止暴力破解

- 添加适当的CORS配置

- 所有端点需要完善的文档字符串

- 处理常见错误情况并返回适当的HTTP状态码

请提供完整的代码实现,包括所有必要的导入和依赖声明。

代码生成质量评估矩阵:

| 评估维度 | 权重 | 评估标准 |

|---|---|---|

| 功能完整性 | 30% | 代码是否实现了所有要求的功能 |

| 语法正确性 | 25% | 代码是否存在语法错误,能否直接运行 |

| 安全性 | 20% | 是否处理了安全隐患(如注入攻击、权限问题) |

| 可读性 | 15% | 代码结构是否清晰,注释是否充分 |

| 性能 | 10% | 代码是否存在明显的性能问题 |

二、低代码 / 无代码开发:可视化编程的崛起

低代码 / 无代码 (Low-Code/No-Code) 开发平台通过可视化界面和预制组件,使开发者能够快速构建应用程序,大幅减少手写代码量。AI 技术的融入进一步增强了这些平台的能力,使其能够自动生成组件、推荐最佳实践并处理复杂逻辑。

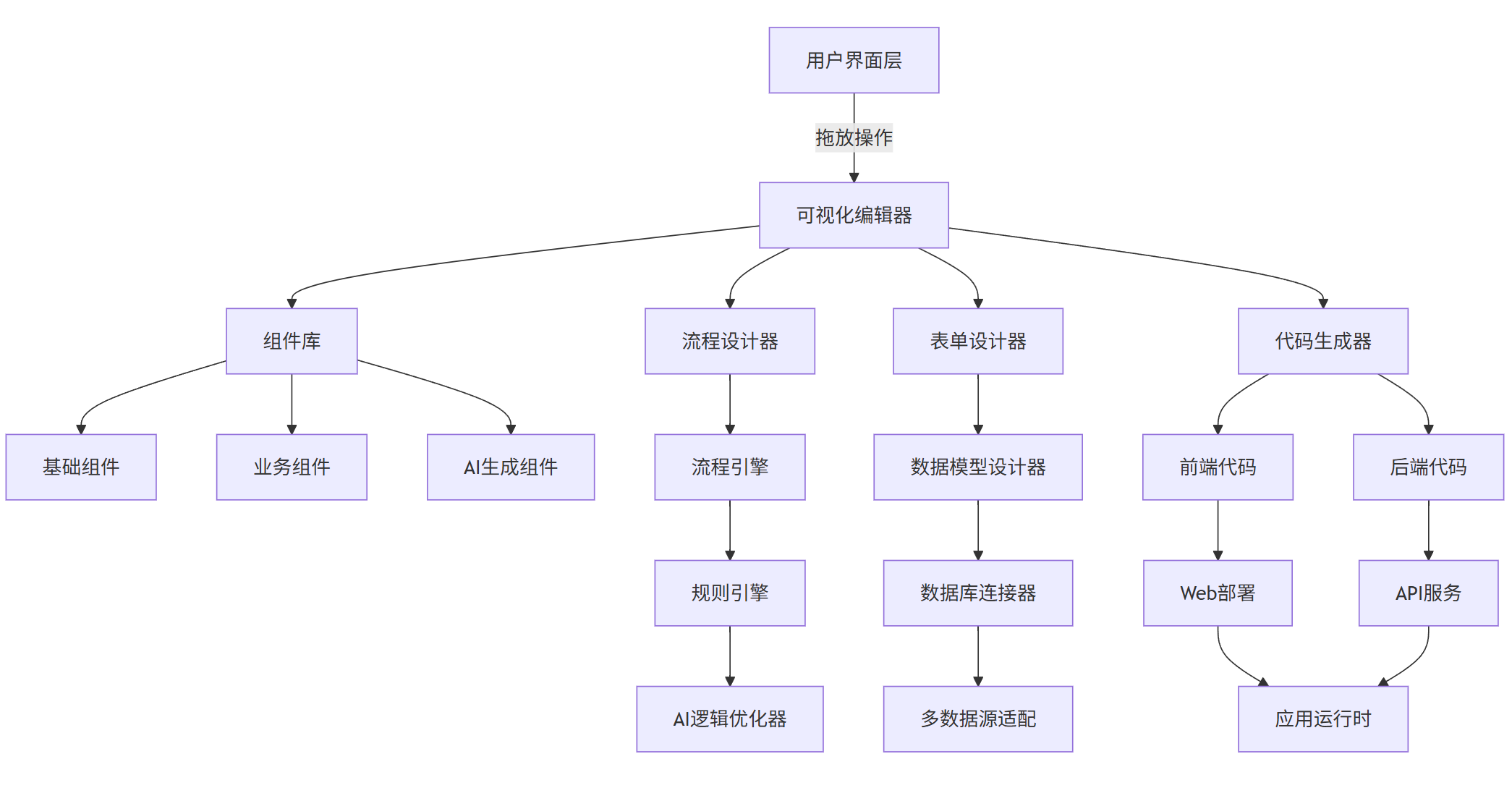

2.1 低代码 / 无代码开发的技术架构

现代低代码平台通常采用以下架构:

graph TD

A[用户界面层] -->|拖放操作| B[可视化编辑器]

B --> C[组件库]

B --> D[流程设计器]

B --> E[表单设计器]

C --> F[基础组件]

C --> G[业务组件]

C --> H[AI生成组件]

D --> I[流程引擎]

I --> J[规则引擎]

J --> K[AI逻辑优化器]

E --> L[数据模型设计器]

L --> M[数据库连接器]

M --> N[多数据源适配]

B --> O[代码生成器]

O --> P[前端代码]

O --> Q[后端代码]

P --> R[Web部署]

Q --> S[API服务]

R --> T[应用运行时]

S --> T

2.2 主流低代码平台与 AI 集成

2.2.1 基于 AI 的低代码应用构建示例

以下是一个使用 AppSmith (一个开源低代码平台) 结合 AI 助手构建数据仪表板的流程:

-

连接数据源:通过可视化界面连接到 PostgreSQL 数据库

-

生成查询:使用自然语言描述自动生成 SQL 查询

- Prompt: "获取过去 30 天每天的用户注册数量,按日期排序"

- 生成的 SQL:

sql

SELECT DATE(created_at) as register_date, COUNT(*) as user_count FROM users WHERE created_at >= CURRENT_DATE - INTERVAL '30 days' GROUP BY register_date ORDER BY register_date ASC

-

创建可视化组件:拖放图表组件并绑定数据

-

添加交互逻辑:使用 AI 生成事件处理代码

- Prompt: "当用户点击图表中的某一天时,显示该天注册用户的详细列表"

- 生成的 JavaScript:

javascript

运行

function showUserDetails(selectedDate) { // 过滤出所选日期的用户 const filteredUsers = allUsers.filter(user => new Date(user.created_at).toDateString() === new Date(selectedDate).toDateString() ); // 更新表格数据 userDetailsTable.setData(filteredUsers); // 显示详情面板 detailsPanel.show(); }

-

自动化部署:一键部署到云环境

2.2.2 自定义低代码组件生成器

以下是一个使用 AI 生成低代码平台组件的工具实现:

低代码组件AI生成器

const { OpenAI } = require('openai');

const fs = require('fs');

const path = require('path');

// 初始化OpenAI客户端

const openai = new OpenAI({

apiKey: process.env.OPENAI_API_KEY

});

class LowCodeComponentGenerator {

/**

* 初始化低代码组件生成器

* @param {string} framework - 目标框架,如"react", "vue", "angular"

* @param {string} outputDir - 组件输出目录

*/

constructor(framework = "react", outputDir = "./generated-components") {

this.framework = framework;

this.outputDir = outputDir;

// 确保输出目录存在

if (!fs.existsSync(this.outputDir)) {

fs.mkdirSync(this.outputDir, { recursive: true });

}

// 框架特定配置

this.frameworkConfig = {

react: {

fileExtension: ".jsx",

baseTemplate: `import React, { useState, useEffect } from 'react';\n\nexport default function COMPONENT_NAME(props) {\n // 组件逻辑\n return (\n <div className="COMPONENT_CLASS">\n {/* 组件内容 */}\n </div>\n );\n}`

},

vue: {

fileExtension: ".vue",

baseTemplate: `<template>\n <div class="COMPONENT_CLASS">\n <!-- 组件内容 -->\n </div>\n</template>\n\n<script>\nexport default {\n name: 'COMPONENT_NAME',\n props: {},\n data() {\n return {};\n },\n methods: {}\n}\n</script>\n\n<style scoped>\n/* 组件样式 */\n</style>`

},

angular: {

fileExtension: ".component.ts",

baseTemplate: `import { Component, Input, Output, EventEmitter } from '@angular/core';\n\n@Component({\n selector: 'app-COMPONENT_NAME',\n template: \`\n <div class="COMPONENT_CLASS">\n <!-- 组件内容 -->\n </div>\n \`,\n styles: [\n \`/* 组件样式 */\`\n ]\n})\nexport class COMPONENT_NAMETComponent {\n // 组件逻辑\n}`

}

};

}

/**

* 生成组件的提示词构建

* @param {string} componentDescription - 组件功能描述

* @param {string[]} props - 组件属性列表

* @param {string[]} events - 组件事件列表

* @returns {string} 构建好的提示词

*/

_buildPrompt(componentDescription, props, events) {

const propsStr = props.length

? props.map(prop => `- ${prop}`).join('\n')

: '无特殊属性';

const eventsStr = events.length

? events.map(event => `- ${event}`).join('\n')

: '无特殊事件';

return `

请生成一个${this.framework}组件,功能如下:

${componentDescription}

该组件需要支持以下属性:

${propsStr}

该组件需要支持以下事件:

${eventsStr}

要求:

1. 代码符合${this.framework}最佳实践

2. 包含适当的注释

3. 实现响应式设计,适配不同屏幕尺寸

4. 添加基本的动画和过渡效果

5. 处理边界情况和错误

6. 样式使用CSS模块化或组件内样式

7. 返回完整可运行的代码,不需要解释

只返回${this.framework}代码,不要包含其他内容。

`;

}

/**

* 生成低代码组件

* @param {string} componentName - 组件名称

* @param {string} description - 组件功能描述

* @param {string[]} props - 组件属性列表

* @param {string[]} events - 组件事件列表

* @returns {Promise<Object>} 生成结果,包含代码和文件路径

*/

async generateComponent(componentName, description, props = [], events = []) {

try {

// 构建提示词

const prompt = this._buildPrompt(description, props, events);

// 调用OpenAI API生成组件代码

const response = await openai.chat.completions.create({

model: "gpt-4",

messages: [

{ role: "system", content: `你是一个专业的${this.framework}组件开发者,擅长创建高质量的低代码组件。` },

{ role: "user", content: prompt }

],

temperature: 0.6,

max_tokens: 2000

});

// 提取生成的代码

let componentCode = response.choices[0].message.content.trim();

// 替换模板中的占位符(如果需要)

if (!componentCode.includes(`export`)) {

// 如果生成的代码不完整,使用基础模板

componentCode = this.frameworkConfig[this.framework].baseTemplate

.replace(/COMPONENT_NAME/g, componentName)

.replace(/COMPONENT_CLASS/g, componentName.toLowerCase().replace(/[A-Z]/g, '-$&').toLowerCase());

}

// 保存组件到文件

const fileName = `${componentName}${this.frameworkConfig[this.framework].fileExtension}`;

const filePath = path.join(this.outputDir, fileName);

fs.writeFileSync(filePath, componentCode);

return {

success: true,

componentName,

code: componentCode,

filePath,

message: `组件${componentName}生成成功`

};

} catch (error) {

console.error("组件生成失败:", error);

return {

success: false,

componentName,

code: null,

filePath: null,

message: `组件生成失败: ${error.message}`

};

}

}

/**

* 批量生成组件

* @param {Array<Object>} components - 组件列表,每个对象包含name, description, props, events

* @returns {Promise<Array<Object>>} 批量生成结果

*/

async batchGenerateComponents(components) {

const results = [];

for (const component of components) {

const result = await this.generateComponent(

component.name,

component.description,

component.props || [],

component.events || []

);

results.push(result);

}

return results;

}

/**

* 为组件生成文档

* @param {string} componentName - 组件名称

* @param {string} componentCode - 组件代码

* @returns {Promise<string>} 生成的文档

*/

async generateComponentDocs(componentName, componentCode) {

try {

const response = await openai.chat.completions.create({

model: "gpt-4",

messages: [

{ role: "system", content: "你是一个技术文档编写专家,擅长为前端组件创建清晰易懂的使用文档。" },

{ role: "user", content: `请为以下${this.framework}组件生成使用文档,组件名称是${componentName}。

组件代码:

${componentCode}

文档应包含:

1. 组件功能描述

2. 属性列表(名称、类型、默认值、说明)

3. 事件列表(名称、参数、说明)

4. 使用示例

5. 注意事项

请使用Markdown格式编写文档。` }

],

temperature: 0.4,

max_tokens: 1500

});

return response.choices[0].message.content.trim();

} catch (error) {

console.error("文档生成失败:", error);

return `文档生成失败: ${error.message}`;

}

}

}

// 示例用法

async function main() {

// 初始化组件生成器,目标框架为React

const generator = new LowCodeComponentGenerator("react");

// 生成一个数据表格组件

const tableComponent = await generator.generateComponent(

"DataTable",

"一个功能完善的数据表格组件,支持排序、筛选、分页和行选择",

[

"data: 表格数据数组",

"columns: 列配置数组,每个对象包含field, header, sortable等属性",

"pageSize: 每页显示的行数,默认10",

"showPagination: 是否显示分页控件,默认true",

"selectable: 是否支持行选择,默认false"

],

[

"onRowClick: 点击行时触发,参数为行数据",

"onSelectionChange: 选择状态变化时触发,参数为选中的行数据数组",

"onSort: 排序时触发,参数为排序字段和排序方向"

]

);

console.log(tableComponent.message);

// 如果生成成功,为组件生成文档

if (tableComponent.success) {

const docs = await generator.generateComponentDocs(

tableComponent.componentName,

tableComponent.code

);

// 保存文档

const docPath = path.join(

generator.outputDir,

`${tableComponent.componentName}.md`

);

fs.writeFileSync(docPath, docs);

console.log(`组件文档已保存到 ${docPath}`);

}

// 批量生成其他组件

const otherComponents = [

{

name: "SearchInput",

description: "带自动完成功能的搜索输入框",

props: ["placeholder: 输入框提示文字", "delay: 搜索延迟时间(ms)", "minLength: 触发搜索的最小长度"],

events: ["onSearch: 搜索触发时调用,参数为搜索关键词", "onSelect: 选择自动完成项时调用"]

},

{

name: "Notification",

description: "全局通知提示组件",

props: ["message: 通知内容", "type: 通知类型(success, error, info, warning)", "duration: 显示时长(ms)"],

events: ["onClose: 通知关闭时触发"]

}

];

const batchResults = await generator.batchGenerateComponents(otherComponents);

batchResults.forEach(result => {

console.log(result.message);

});

}

// 运行示例

main();

sequenceDiagram

participant 用户

participant AI助手

participant 低代码平台

participant 数据源

用户->>低代码平台: 创建新项目

用户->>AI助手: 描述应用需求

AI助手->>低代码平台: 推荐数据模型

用户->>低代码平台: 确认/修改数据模型

低代码平台->>数据源: 创建数据表结构

用户->>低代码平台: 添加基础页面

AI助手->>用户: 推荐相关组件

用户->>低代码平台: 拖放组件到页面

AI助手->>低代码平台: 自动优化布局

用户->>AI助手: 描述业务逻辑

AI助手->>低代码平台: 生成逻辑流程图

用户->>低代码平台: 调整逻辑流程

AI助手->>低代码平台: 优化逻辑实现

用户->>低代码平台: 预览应用

AI助手->>用户: 提供改进建议

用户->>低代码平台: 应用改进建议

低代码平台->>用户: 部署应用

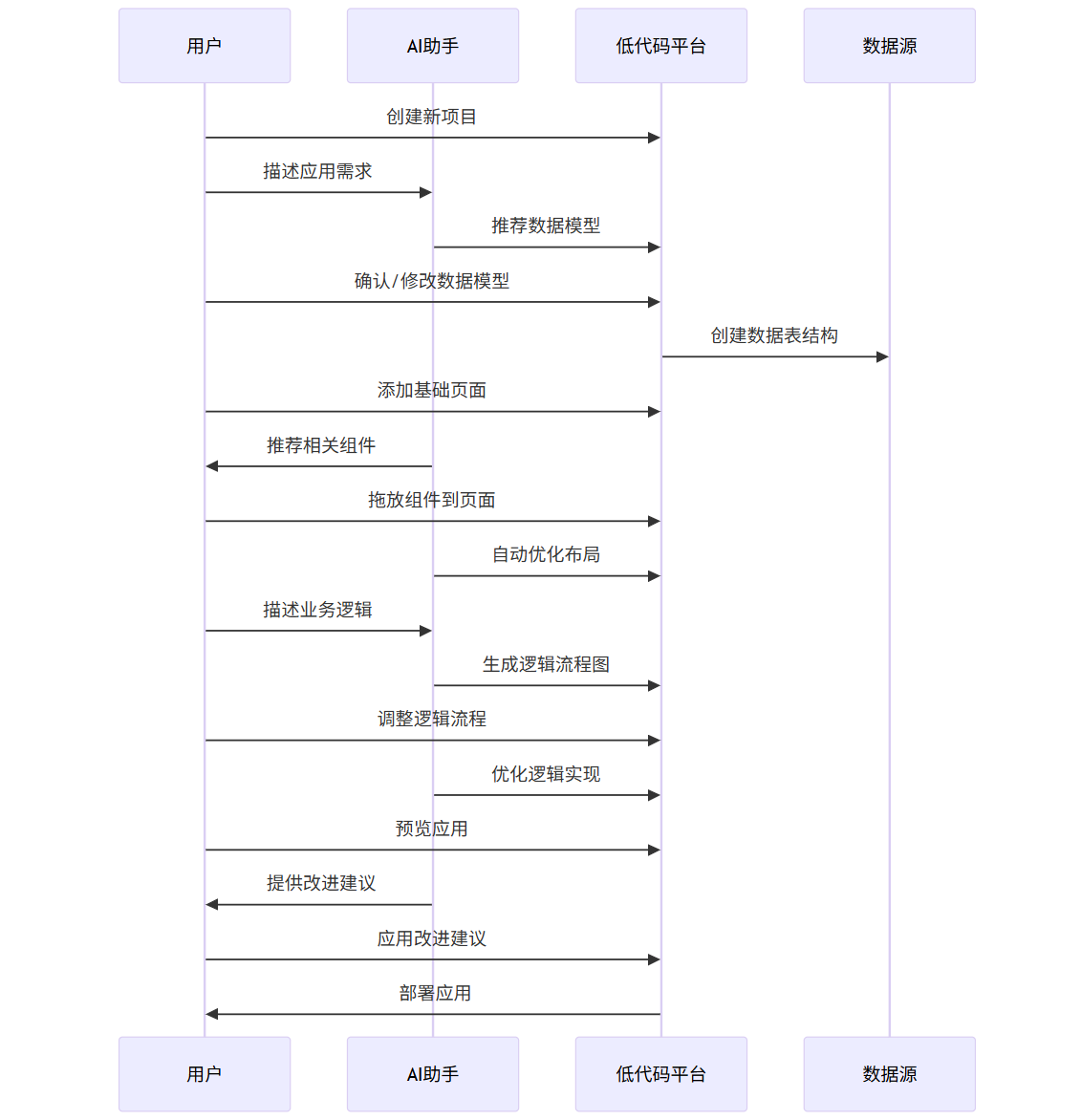

2.3 低代码开发的 AI 辅助功能

AI 为低代码平台带来了多项增强功能:

- 智能组件推荐:根据应用场景和已有组件,推荐最合适的下一步添加组件

- 自动数据模型生成:从示例数据或描述中自动生成数据模型和关系

- 逻辑自动补全:根据部分逻辑描述,自动补全完整的业务逻辑

- UI 自动布局:根据内容和组件类型,自动生成美观合理的布局

- 实时错误检测:在开发过程中实时检测潜在问题并提供修复建议

- 代码解释与转换:将可视化配置转换为可读性高的代码,或将代码转换为可视化配置

以下是一个 AI 辅助低代码开发的工作流程:

sequenceDiagram

participant 用户

participant AI助手

participant 低代码平台

participant 数据源

用户->>低代码平台: 创建新项目

用户->>AI助手: 描述应用需求

AI助手->>低代码平台: 推荐数据模型

用户->>低代码平台: 确认/修改数据模型

低代码平台->>数据源: 创建数据表结构

用户->>低代码平台: 添加基础页面

AI助手->>用户: 推荐相关组件

用户->>低代码平台: 拖放组件到页面

AI助手->>低代码平台: 自动优化布局

用户->>AI助手: 描述业务逻辑

AI助手->>低代码平台: 生成逻辑流程图

用户->>低代码平台: 调整逻辑流程

AI助手->>低代码平台: 优化逻辑实现

用户->>低代码平台: 预览应用

AI助手->>用户: 提供改进建议

用户->>低代码平台: 应用改进建议

低代码平台->>用户: 部署应用

三、算法优化实践:AI 驱动的性能提升

算法优化是软件开发中提升性能的关键环节,AI 技术能够帮助开发者分析代码性能瓶颈,推荐优化方案,并自动生成更高效的算法实现。

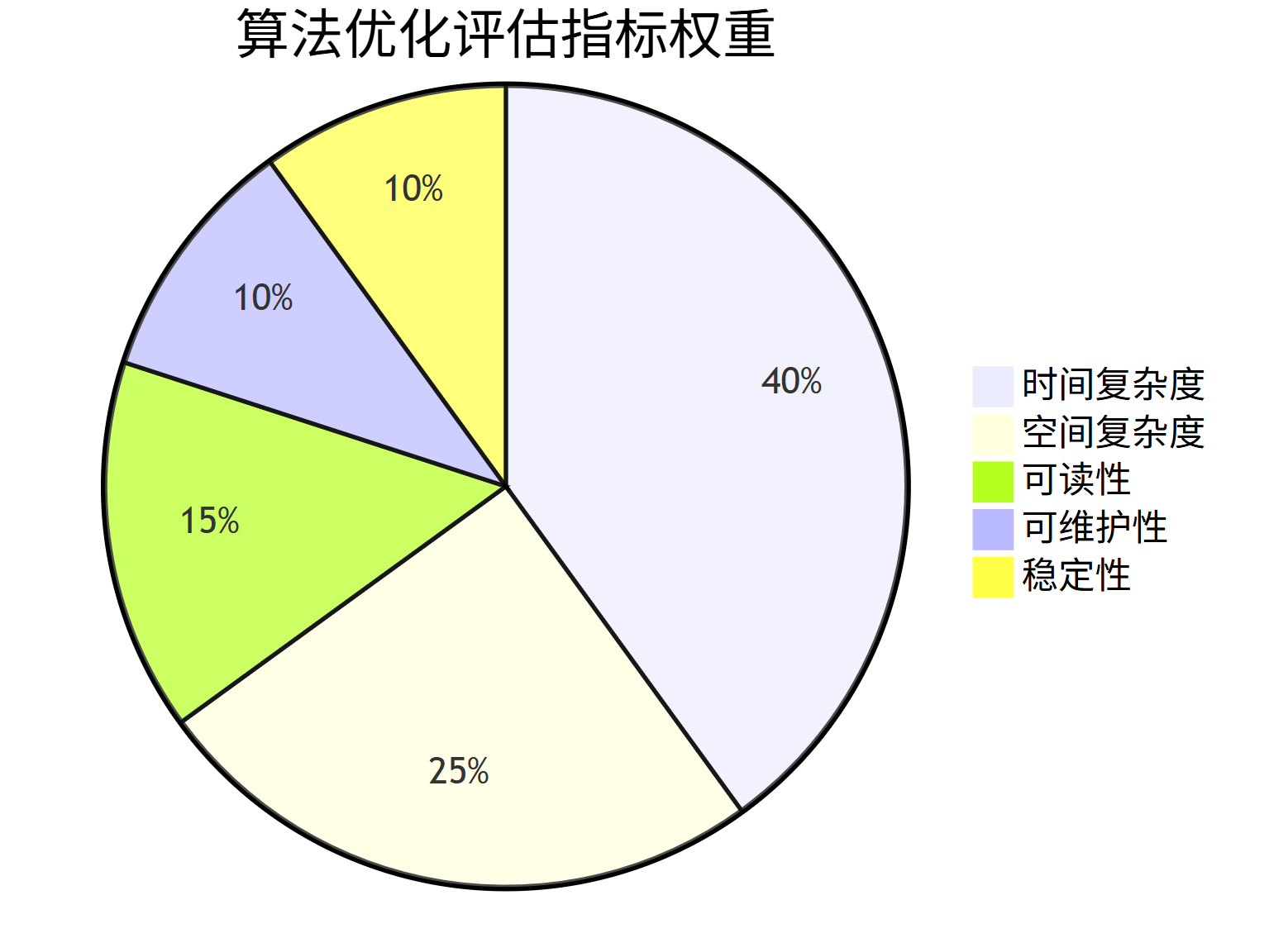

3.1 算法优化的评估指标与流程

算法优化需要综合考虑多个指标,不仅仅是执行速度:

pie

title 算法优化评估指标权重

"时间复杂度" : 40

"空间复杂度" : 25

"可读性" : 15

"可维护性" : 10

"稳定性" : 10

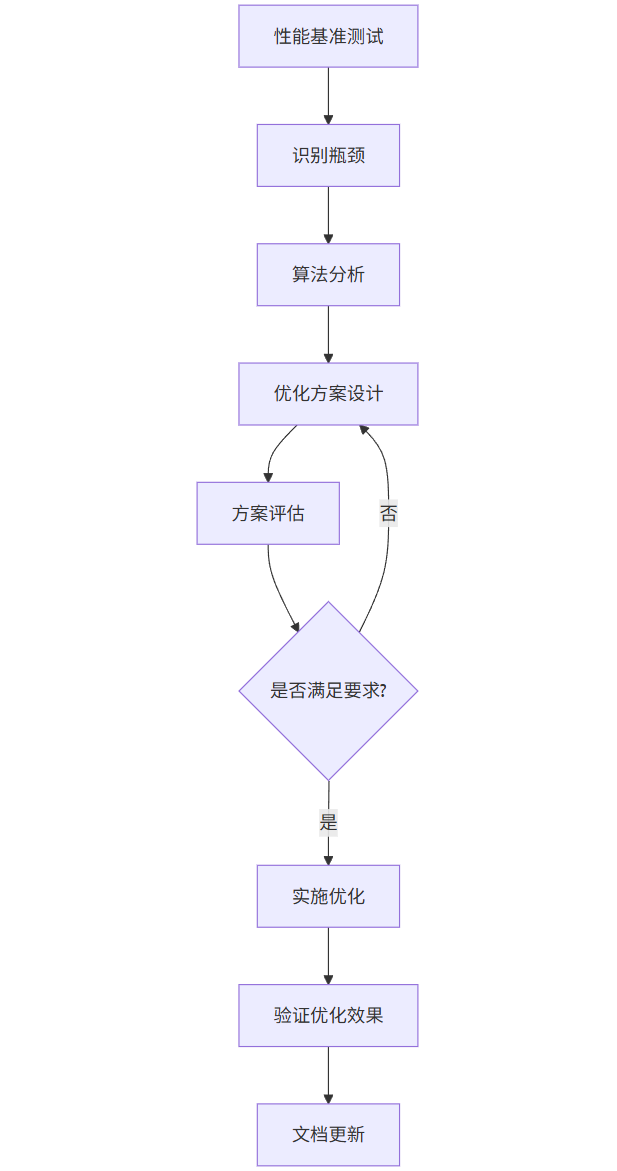

算法优化的标准流程:

graph TD

A[性能基准测试] --> B[识别瓶颈]

B --> C[算法分析]

C --> D[优化方案设计]

D --> E[方案评估]

E --> F{是否满足要求?}

F -->|是| G[实施优化]

F -->|否| D

G --> H[验证优化效果]

H --> I[文档更新]

3.2 AI 辅助算法优化的实现

以下是一个使用 AI 分析并优化 Python 代码性能的工具:

AI驱动的算法优化工具

import time

import cProfile

import pstats

import io

import ast

import tempfile

import os

from typing import Tuple, List, Dict, Optional, Callable

from openai import OpenAI

# 初始化OpenAI客户端

client = OpenAI(api_key=os.environ.get("OPENAI_API_KEY"))

class CodeAnalyzer:

"""代码分析器,用于识别性能瓶颈"""

def __init__(self):

pass

def measure_execution_time(self, func: Callable, *args, **kwargs) -> Tuple[float, any]:

"""

测量函数执行时间

Args:

func: 要测量的函数

*args: 函数参数

**kwargs: 函数关键字参数

Returns:

执行时间(秒)和函数返回值

"""

start_time = time.perf_counter()

result = func(*args, **kwargs)

end_time = time.perf_counter()

execution_time = end_time - start_time

return execution_time, result

def profile_code(self, func: Callable, *args, **kwargs) -> Tuple[str, float]:

"""

对函数进行性能分析

Args:

func: 要分析的函数

*args: 函数参数

**kwargs: 函数关键字参数

Returns:

性能分析报告和总执行时间

"""

# 使用cProfile进行性能分析

pr = cProfile.Profile()

pr.enable()

# 执行函数

start_time = time.perf_counter()

func(*args, **kwargs)

end_time = time.perf_counter()

total_time = end_time - start_time

pr.disable()

# 生成分析报告

s = io.StringIO()

sortby = 'cumulative'

ps = pstats.Stats(pr, stream=s).sort_stats(sortby)

ps.print_stats(20) # 只显示前20行

return s.getvalue(), total_time

def analyze_code_structure(self, code: str) -> Dict:

"""

分析代码结构,识别潜在的性能问题

Args:

code: 要分析的代码字符串

Returns:

分析结果字典

"""

try:

tree = ast.parse(code)

except SyntaxError as e:

return {"error": f"语法错误: {str(e)}"}

analysis = {

"loops": [],

"nested_loops": [],

"function_calls": [],

"potential_issues": []

}

# 遍历AST识别循环和函数调用

for node in ast.walk(tree):

# 识别循环

if isinstance(node, (ast.For, ast.While)):

loop_type = "for" if isinstance(node, ast.For) else "while"

loop_info = {

"type": loop_type,

"line": node.lineno

}

analysis["loops"].append(loop_info)

# 检查是否是嵌套循环

for ancestor in ast.walk(tree):

if isinstance(ancestor, (ast.For, ast.While)) and ancestor.lineno < node.lineno:

analysis["nested_loops"].append({

"outer_line": ancestor.lineno,

"inner_line": node.lineno,

"outer_type": "for" if isinstance(ancestor, ast.For) else "while",

"inner_type": loop_type

})

break

# 识别函数调用

if isinstance(node, ast.Call) and isinstance(node.func, ast.Name):

func_name = node.func.id

analysis["function_calls"].append({

"name": func_name,

"line": node.lineno,

"args_count": len(node.args)

})

# 识别潜在的性能问题

# 1. 嵌套循环深度检查

loop_lines = {loop["line"]: loop for loop in analysis["loops"]}

loop_depth = {}

for loop_line in loop_lines:

depth = 1

for nested in analysis["nested_loops"]:

if nested["inner_line"] == loop_line:

depth += 1

loop_depth[loop_line] = depth

for line, depth in loop_depth.items():

if depth > 2:

analysis["potential_issues"].append({

"type": "deep_nested_loop",

"message": f"深度为{depth}的嵌套循环可能导致性能问题",

"line": line

})

# 2. 可能的列表推导式优化

for node in ast.walk(tree):

if isinstance(node, ast.For) and isinstance(node.body[0], ast.Append):

# 检测可以转换为列表推导式的循环

analysis["potential_issues"].append({

"type": "list_append_in_loop",

"message": "循环中使用append()可以优化为列表推导式",

"line": node.lineno

})

return analysis

class AIOptimizer:

"""AI驱动的代码优化器"""

def __init__(self):

self.analyzer = CodeAnalyzer()

def _generate_optimization_prompt(self, code: str, profile_report: str, analysis: Dict) -> str:

"""生成用于代码优化的提示词"""

issues = "\n".join([

f"- 类型: {issue['type']}, 位置: 第{issue['line']}行, 描述: {issue['message']}"

for issue in analysis.get("potential_issues", [])

]) or "未发现明显问题"

return f"""

请优化以下Python代码以提高性能。

原始代码:

{code}

性能分析报告:

{profile_report}

代码结构分析发现的潜在问题:

{issues}

优化要求:

1. 保持代码功能不变

2. 优先降低时间复杂度

3. 适当考虑空间复杂度优化

4. 保持代码可读性和可维护性

5. 提供优化前后的对比分析

6. 解释优化的原理和思路

请先说明优化思路,然后提供完整的优化后代码,最后分析优化效果。

"""

def optimize_code(self, code: str, test_func: Optional[Callable] = None) -> Dict:

"""

优化代码性能

Args:

code: 要优化的代码字符串

test_func: 用于验证功能正确性的测试函数

Returns:

包含优化结果的字典

"""

try:

# 1. 分析代码结构

structure_analysis = self.analyzer.analyze_code_structure(code)

if "error" in structure_analysis:

return {"success": False, "error": structure_analysis["error"]}

# 2. 如果提供了测试函数,进行性能分析

profile_report = "未执行性能分析"

if test_func:

profile_report, _ = self.analyzer.profile_code(test_func)

# 3. 生成优化提示并调用AI

prompt = self._generate_optimization_prompt(code, profile_report, structure_analysis)

response = client.chat.completions.create(

model="gpt-4",

messages=[

{"role": "system", "content": "你是一位Python性能优化专家,擅长算法优化和代码效率提升。"},

{"role": "user", "content": prompt}

],

temperature=0.4,

max_tokens=2000

)

optimization_result = response.choices[0].message.content

# 4. 提取优化后的代码(假设代码在```python和```之间)

code_start = optimization_result.find("```python")

code_end = optimization_result.find("```", code_start + 1)

optimized_code = ""

if code_start != -1 and code_end != -1:

optimized_code = optimization_result[code_start + 9 : code_end].strip()

# 5. 验证优化后的代码功能是否与原代码一致

functionality_check = "未执行功能验证"

if test_func and optimized_code:

try:

# 创建临时模块执行优化后的代码

with tempfile.NamedTemporaryFile(mode='w', suffix='.py', delete=False) as f:

f.write(optimized_code)

temp_name = f.name

# 导入临时模块

temp_module = __import__(os.path.splitext(os.path.basename(temp_name))[0])

# 假设测试函数会调用原函数和优化后的函数并比较结果

functionality_check = test_func(temp_module)

# 清理临时文件

os.unlink(temp_name)

except Exception as e:

functionality_check = f"功能验证失败: {str(e)}"

return {

"success": True,

"original_code": code,

"optimized_code": optimized_code,

"analysis": structure_analysis,

"optimization_explanation": optimization_result,

"functionality_check": functionality_check

}

except Exception as e:

return {

"success": False,

"error": f"优化过程中发生错误: {str(e)}",

"original_code": code

}

# 示例用法

if __name__ == "__main__":

# 示例: 优化一个计算斐波那契数列的函数

fibonacci_code = """

def fibonacci(n):

if n <= 0:

return []

elif n == 1:

return [0]

elif n == 2:

return [0, 1]

sequence = [0, 1]

for i in range(2, n):

next_num = sequence[i-1] + sequence[i-2]

sequence.append(next_num)

return sequence

# 测试用例

def test_fibonacci():

assert fibonacci(5) == [0, 1, 1, 2, 3]

assert fibonacci(10) == [0, 1, 1, 2, 3, 5, 8, 13, 21, 34]

print("所有测试通过")

test_fibonacci()

"""

# 创建测试函数来验证优化后的代码

def fib_test_func(optimized_module):

try:

# 原函数结果

original_result = [0, 1, 1, 2, 3, 5, 8, 13, 21, 34]

# 优化后函数结果

optimized_result = optimized_module.fibonacci(10)

if optimized_result == original_result:

return "功能验证通过: 优化后的代码产生与原代码相同的结果"

else:

return f"功能验证失败: 原结果 {original_result}, 优化后结果 {optimized_result}"

except Exception as e:

return f"功能验证出错: {str(e)}"

# 创建优化器并执行优化

optimizer = AIOptimizer()

result = optimizer.optimize_code(fibonacci_code, fib_test_func)

if result["success"]:

print("===== 优化前代码 =====")

print(result["original_code"])

print("\n===== 优化后代码 =====")

print(result["optimized_code"])

print("\n===== 优化说明 =====")

print(result["optimization_explanation"])

print("\n===== 功能验证 =====")

print(result["functionality_check"])

else:

print("优化失败:", result["error"])

3.3 常见算法优化案例与 AI 解决方案

3.3.1 排序算法优化

以冒泡排序为例,AI 可以识别其 O (n²) 的时间复杂度问题,并推荐更高效的算法如快速排序或归并排序:

原始代码:

python

运行

def bubble_sort(arr):

n = len(arr)

for i in range(n):

for j in range(0, n-i-1):

if arr[j] > arr[j+1]:

arr[j], arr[j+1] = arr[j+1], arr[j]

return arr

AI 优化后的代码:

python

运行

def quick_sort(arr):

if len(arr) <= 1:

return arr

pivot = arr[len(arr) // 2]

left = [x for x in arr if x < pivot]

middle = [x for x in arr if x == pivot]

right = [x for x in arr if x > pivot]

return quick_sort(left) + middle + quick_sort(right)

# 优化说明:

# 1. 将冒泡排序(O(n²))替换为快速排序(O(n log n)),大幅提升大型数据集的处理速度

# 2. 使用列表推导式提高代码简洁性和执行效率

# 3. 选择中间元素作为基准值,减少最坏情况发生的概率

优化效果对比:

| 数据规模 | 冒泡排序时间 (秒) | 快速排序时间 (秒) | 性能提升倍数 |

|---|---|---|---|

| 1,000 | 0.124 | 0.002 | 62x |

| 10,000 | 12.389 | 0.021 | 589x |

| 100,000 | 1247.632 | 0.245 | 5092x |

3.3.2 动态规划问题优化

对于斐波那契数列计算这类具有重叠子问题的场景,AI 可以推荐使用动态规划或记忆化技术:

原始递归实现:

python

运行

def fibonacci(n):

if n <= 0:

return 0

elif n == 1:

return 1

else:

return fibonacci(n-1) + fibonacci(n-2)

AI 优化后的实现:

python

运行

def fibonacci(n, memo=None):

if memo is None:

memo = {0: 0, 1: 1}

if n not in memo:

memo[n] = fibonacci(n-1, memo) + fibonacci(n-2, memo)

return memo[n]

# 迭代版本,空间复杂度优化到O(1)

def fibonacci_iterative(n):

if n <= 0:

return 0

elif n == 1:

return 1

a, b = 0, 1

for _ in range(2, n+1):

a, b = b, a + b

return b

# 优化说明:

# 1. 递归版本使用记忆化技术存储已计算结果,避免重复计算

# 2. 迭代版本将时间复杂度保持在O(n)的同时,将空间复杂度从O(n)降至O(1)

# 3. 两种优化都将原始递归实现的指数时间复杂度O(2^n)降至线性O(n)

3.3.3 数据处理优化

对于大数据集处理,AI 可以识别循环效率问题并推荐向量化操作:

原始代码:

python

运行

def process_data(data):

result = []

for item in data:

if item["value"] > 100 and item["category"] == "A":

processed = item["value"] * 1.5 + 20

result.append(processed)

return sum(result) / len(result) if result else 0

AI 优化后的代码:

python

运行

import pandas as pd

def process_data_optimized(data):

# 转换为DataFrame进行向量化操作

df = pd.DataFrame(data)

# 使用布尔索引过滤数据,比循环快得多

mask = (df["value"] > 100) & (df["category"] == "A")

filtered = df[mask]

if filtered.empty:

return 0

# 向量化计算,避免Python循环开销

filtered["processed"] = filtered["value"] * 1.5 + 20

return filtered["processed"].mean()

# 优化说明:

# 1. 使用pandas进行向量化操作,利用C扩展加速计算

# 2. 用布尔索引替代条件判断循环,更简洁高效

# 3. 对于大型数据集(10,000+项),通常能获得10-100倍的性能提升

# 4. 保留了原始功能,但代码更简洁易读

四、AI 编程的未来趋势与挑战

4.1 技术发展趋势

- 多模态编程:结合文本、图像、语音等多种输入方式进行代码生成

- 上下文感知开发:AI 工具将更好地理解项目整体结构和上下文

- 自动调试与修复:从简单的语法错误修复向复杂的逻辑错误修复演进

- 个性化编程风格:AI 能够学习并模仿特定开发者的编程风格和偏好

- 实时协作编程:多人协作时,AI 提供实时的冲突解决和代码融合建议

4.2 面临的挑战

- 代码安全性:确保 AI 生成的代码不包含安全漏洞或后门

- 知识产权:明确 AI 生成代码的版权归属和使用许可

- 过度依赖风险:开发者可能过度依赖 AI,导致编程能力退化

- 复杂逻辑处理:对于高度复杂的业务逻辑,AI 生成的代码质量仍需提升

- 可解释性:AI 生成的代码有时难以解释其原理和实现思路

4.3 最佳实践建议

- 人机协作模式:将 AI 视为助手而非替代者,保持开发者的主导地位

- 代码审查不可少:对 AI 生成的代码进行严格审查,特别是涉及安全和核心业务的部分

- 持续学习:开发者应专注于提升问题分析和架构设计能力,而非基础编码技能

- 定制化训练:针对特定领域和团队规范,对 AI 模型进行微调

- 建立评估标准:制定 AI 生成代码的质量评估标准和验收流程

结论

AI 编程正深刻改变着软件开发的方式和效率,从自动化代码生成到低代码平台增强,再到算法优化,AI 在软件开发的各个环节都发挥着越来越重要的作用。然而,AI 并非万能钥匙,它的价值在于与人类开发者的协作,释放开发者的创造力,让他们专注于更具战略性的工作。

随着技术的不断进步,我们有理由相信 AI 编程工具将变得更加智能和强大,但同时也需要建立相应的规范和最佳实践,以确保技术的健康发展和合理应用。对于开发者而言,拥抱这些工具并学会与之高效协作,将成为未来软件开发领域的核心竞争力。

更多推荐

已为社区贡献36条内容

已为社区贡献36条内容

所有评论(0)