我想创建一种适合中国人普通人们的编程语言,即使只有小学文化,也可以进行编程。这个编程语言具有如下特色:1 中文关键字,类arc(lisp方言)的语法 2 编译后执行速度快,基本跟c++差不多。 3 可

摘要:本文提出了一种面向低学历人群的中文编程语言设计方案,采用Lisp-like语法结构,支持中文关键字。该语言通过LLVM后端实现高性能编译,支持WebAssembly输出和并行执行,并内置AI功能接口。技术方案采用"中文前端+LLVM/Wasm后端"架构,利用ANTLR4/Rust实现词法语法解析,通过inkwell生成LLVM-IR,整合OpenMP并行计算和ONNX运行

我想创建一种适合中国人普通人们的编程语言,即使只有小学文化,也可以进行编程。这个编程语言具有如下特色:1 中文关键字,类arc(lisp方言)的语法 2 编译后执行速度快,基本跟c++差不多。 3 可以并行执行 4 可以像moonbit那样原生支持WebAssembly(Wasm)后端,可以编译成wasm 5 AI原生支持 。 5 可以调用c++ 库和python库

先说结论

这回AI返回的信息真的很靠谱:

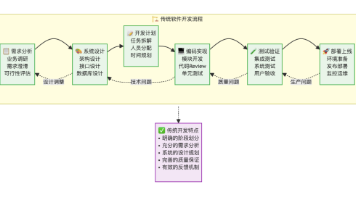

把“面向小学文化的中文 Lisp‑Like 编程语言” 当作 一个 ** “中文前端 + 现成后端 (LLVM + Wasm + FFI) ” 的 项目**,而不是从零把整个编译器、运行时、并行调度、AI 加速、WebAssembly 生成全部手写。

下面给出 完整的技术路线、实现步骤、关键工具、示例代码、常见坑,帮助你快速搭出原型,并在此基础上迭代到工业级产品。

1️⃣ 项目定位与核心目标

| 目标 | 说明 | 实现思路 |

|---|---|---|

| 中文关键字 | 所有语言元素(def、if、while、import 等)使用中文 | 词法层面采用 Unicode 兼容的中文标识符,使用 ANTLR4 或 Rust‑Lex 自定义词法 |

| Lisp‑Like 语法 | S‑表达式(圆括号嵌套)为主,兼容简洁的“前置函数”写法 | 直接把源代码解析成 AST,再交给后端进行代码生成 |

| 编译速度 & 运行性能 ≈ C++ | 目标是生成 本地机器码 或 WebAssembly,不走解释器路径 | 使用 LLVM 作为代码生成后端(LLVM‑IR → 本地机器码 / Wasm) |

| 并行执行 | 支持多线程、协程或数据并行 | 依赖 LLVM‑OpenMP、std::thread 或 Rayon‑style 并行库,在前端加入 并行/并发 关键字 |

| 原生 Wasm 支持 | 可以“一键”编译成 Wasm 并在浏览器/Node 中运行 | LLVM 已提供 WebAssembly backend,只要把 LLVM‑IR 输出为 .wasm 即可 |

| AI 原生支持 | 能直接调用 TensorFlow、ONNX、LLM 等模型 | 通过 FFI 链接 C++ AI 库(如 TensorFlow C API)或 Python C‑API;提供中文包装宏 加载模型、推理 |

| 调用 C++ & Python 库 | 与现有生态无缝集成 | 生成 C ABI 接口 + cffi / pybind11 的绑定层,前端提供 调用 关键字 |

核心思路:前端(中文 Lisp) → 中间层(LLVM‑IR) → 后端(本地机器码 / Wasm)。这样既能保持语法简洁,又能借助成熟的编译器基础设施保证性能和生态兼容。

2️⃣ 技术选型总览

| 组件 | 推荐实现 | 关键优势 |

|---|---|---|

| 词法/语法 | ANTLR4(中文语法)或 Rust‑Lex + LALRPOP | 强大的错误定位、IDE 插件支持、跨语言生成 |

| 前端 AST | 自定义 Rust 结构体(使用 enum 表示 S‑Expression) | 内存安全、模式匹配便于后端转译 |

| 类型系统 | 静态 + 可选动态(类似 TypeScript) • 基础类型:整数、浮点、布尔、字符串、列表、字典 • 可选 结构体 与 接口 |

为 LLVM 提供完整的类型信息,兼容 C++/Wasm |

| 代码生成 | LLVM(via inkwell / llvm-sys) | 生成本地机器码、Wasm、LLVM‑IR 可视化、成熟的优化 Pass |

| 并行模型 | OpenMP(通过 LLVM) 或 Rayon‑style 任务调度(在运行时库实现) |

与原生 C++ 并行相兼容,易于在 Wasm 中使用 Web Workers |

| AI 接口 | TensorFlow C API、ONNX Runtime C API、ggml(轻量 LLM) | C 接口易于通过 FFI 暴露给语言运行时 |

| FFI / 跨语言 | cbindgen 生成 C 头 + cffi(Python) | 统一调用约定,支持 调用_cpp、调用_py 关键字 |

| 构建工具 | cargo(Rust) + CMake(C++) | 跨平台、易集成 CI/CD |

| IDE 支持 | VS Code 扩展(基于 Language Server Protocol) | 自动补全、错误高亮、中文关键字提示 |

| 测试框架 | Rust test + wasm-pack test | 同时验证本地和 Wasm 行为 |

3️⃣ 语言设计细节

3.1 词法(Lexical)——中文关键字 & 标识符

| 中文关键字 | 对应英文 | 类别 |

|---|---|---|

定义 |

def |

函数/变量定义 |

如果 |

if |

条件 |

否则 |

else |

条件 |

循环 |

while |

循环 |

返回 |

return |

返回值 |

导入 |

import |

模块 |

并行 |

parallel |

并行块 |

加载模型 |

load_model |

AI |

推理 |

infer |

AI |

调用_cpp |

call_cpp |

FFI |

调用_py |

call_py |

FFI |

标识符 采用 Unicode 包含中文、英文字母、数字、下划线,首字符必须是汉字或英文字母(避免冲突)。示例:

变量1、计数器、myFunc。

3.2 语法(Grammar)—— S‑Expression 示例

; 定义一个求阶乘的函数

(定义 阶乘 (参数 n)

(如果 (<= n 1)

1

(* n (阶乘 (- n 1)))))

; 并行求数组每个元素的平方

(并行

(定义 结果 (列表 ))

(遍历 (参数 i (取列表 数据源))

(加入 结果 (乘 i i))))

; 加载并使用 AI 模型

(定义 情感分析 (参数 文本)

(定义 模型 (加载模型 "sentiment.onnx"))

(返回 (推理 模型 文本)))

每一次左括号 ( 开始一个 表达式,内部第一个 token 必为操作符/关键字,后面是其参数。

3.3 类型系统(简化版)

| 类型 | 示例 | 备注 |

|---|---|---|

整数 |

42 |

64‑bit |

浮点 |

3.14 |

IEEE 754 |

布尔 |

真 / 假 |

|

字符串 |

"你好" |

UTF‑8 |

列表 |

(列表 1 2 3) |

可变 |

字典 |

(字典 ("键" 1) ("另一键" 2)) |

|

函数 |

(定义 f (参数 x) (* x x)) |

第一类对象 |

结构体 |

(结构体 人 (字段 名称 字符串) (字段 年龄 整数)) |

可导出 C ABI |

外部库 |

调用_cpp "math" "sqrt" |

FFI |

类型检查 在 AST → LLVM‑IR 转换阶段完成;若想保留动态特性,可在运行时使用 Tag‑Union(类似 Rust 的 enum)。

3.4 并行模型

- 并行块

(并行 {...}):编译器将块内部的独立表达式包装成 Task,运行时使用 线程池(基于rayon)调度。 - 数据并行:提供

并行映射关键字,例如(并行映射 (参数 x 列表) (函数体 ...)),后端生成 OpenMP SIMD 或 Wasm SIMD。

3.5 AI 原生支持

- 模型加载:

(加载模型 "path/to/model.onnx")→ 调用 ONNX Runtime C API,返回内部句柄。 - 推理:

(推理 模型 参数列表)→ 将参数封装为 Tensor,调用OrtRun。 - 为了在 Wasm 中使用 AI,可集成 ggml(纯 C)编译为 Wasm,无需额外依赖。

示例(调用 ONNX)

(定义 翻译 (参数 文本)

(定义 模型 (加载模型 "translate.onnx"))

(返回 (推理 模型 (列表 文本))))

3.6 FFI(C++ / Python)

- C++

; 调用外部 C++ 库函数 foo(int) -> int (定义 调用_foo (参数 x) (调用_cpp "libfoo.so" "foo" x)) - Python

(定义 调用_numpy_sum (参数 列表) (调用_py "numpy" "sum" 列表))

运行时会 生成临时的 C 绑定代码(通过 cbindgen),编译成动态库后加载。Python 调用使用 cpython C-API 或 pyo3(Rust → Python)实现。

4️⃣ 编译器实现路线

下面给出从 源码 到 可执行 / Wasm 的完整流水线,代码示例均使用 Rust(因为 Rust 在系统编程、LLVM 绑定、并发方面都有成熟生态)。

4.1 前端:词法 + 语法

- ANTLR4(推荐):

- 编写

Lang.g4,把中文关键字映射为 token 类型。 - 生成 Rust 目标(使用

antlr4rs),得到 Lexer、Parser。

- 编写

- 手写 Lexer/Parser(使用

logos+LALRPOP)- 词法

logos支持 Unicode。 LALRPOP编写语法规则,直接产出 AST。

- 词法

AST 示例(Rust):

enum Expr {

Def { name: String, params: Vec<String>, body: Box<Expr> },

If { cond: Box<Expr>, then_br: Box<Expr>, else_br: Option<Box<Expr>> },

Call { func: String, args: Vec<Expr> },

Literal(Literal),

// ...

}

Copy4.2 语义分析 & 类型检查

- 建立 SymbolTable(作用域栈),记录函数、变量、结构体信息。

- 在遍历 AST 时进行 类型推导,若不兼容抛出错误。

- 对 并行块 检查副作用(如不允许同一变量被多线程写)。

4.3 中间表示(IR)生成

使用 inkwell(LLVM 的 Rust 封装):

fn gen_expr<'ctx>(ctx: &'ctx Context, builder: &Builder<'ctx>, expr: &Expr) -> BasicValueEnum<'ctx> {

match expr {

Expr::Literal(lit) => match lit {

Literal::Int(i) => ctx.i64_type().const_int(*i as u64, false).into(),

Literal::Str(s) => builder.build_global_string_ptr(s, "str").as_pointer_value().into(),

// ...

},

Expr::Call { func, args } => {

let fn_val = module.get_function(func).expect("未定义函数");

let arg_vals: Vec<BasicMetadataValueEnum> = args.iter()

.map(|a| gen_expr(ctx, builder, a).into())

.collect();

builder.build_call(fn_val, &arg_vals, "calltmp").try_as_basic_value().left().unwrap()

},

// ...

}

}

Copy- 函数、结构体 翻译为 LLVM Function / StructType。

- 并行块 使用

llvm::omp标记或 Rayon 运行时调用(在运行时库中实现parallel_execute)。

4.4 优化与代码生成

- 启用 LLVM 的常规 Pass:

-O2,-march=native。 - 对 Wasm 编译时指定目标

wasm32-unknown-unknown,并开启 wasm-simd。

# 本地可执行文件

clang -O2 -march=native -o myprog myprog.ll

# Wasm 输出

llc -march=wasm32 -filetype=obj myprog.ll -o myprog.o

wasm-ld myprog.o -o myprog.wasm --no-entry --export-all

Copy4.5 运行时库(Runtime)

提供 中文 API 包装在 libmyruntime.so(或 .dll):

#[no_mangle]

pub extern "C" fn 并行_execute(tasks: *const Task, len: usize) {

// 使用 rayon 调度

let slice = unsafe { std::slice::from_raw_parts(tasks, len) };

slice.par_iter().for_each(|t| (t.fn_ptr)(t.arg));

}

Copy- FFI:

call_cpp、call_py通过dlopen动态加载,使用 C-ABI。 - AI:加载模型后返回句柄(指针),提供

infer接口。

4.6 打包与发布

- CLI:

myc(My Chinese)命令行工具myc src.mc -o out.exe(本地)myc src.mc -target wasm -o out.wasm(Wasm)

- IDE Extension:基于 LSP(Language Server Protocol)

- 自动完成关键字、错误定位、代码格式化(使用

rustfmt同理)

- 自动完成关键字、错误定位、代码格式化(使用

- 标准库:提供

数学,集合,并发,网络,AI等模块,全部采用中文名称。

5️⃣ Step‑by‑Step 开发路线图

| 阶段 | 目标 | 关键里程碑 | 预计工作量 |

|---|---|---|---|

| 0. 项目准备 | 搭建仓库、CI、代码规范 | GitHub + Cargo + CMake, 自动运行 cargo fmt/clippy |

1 天 |

| 1. 词法/语法 | 完成中文关键字的 Lexer/Parser,能够生成 AST | ✅ ANTLR4 生成 Rust parser,cargo test 通过最小示例 |

1‑2 周 |

| 2. 基础语义 | 实现变量/函数定义、基本表达式求值(解释器模式) | ✅ 解释运行 能运行 def foo(x) (+ x 1) |

2‑3 周 |

| 3. LLVM 后端 | 把 AST 翻译成 LLVM‑IR,生成本地可执行文件 | ✅ myc hello.mc -o hello 产生 hello.exe,运行结果正确 |

3‑4 周 |

| 4. Wasm 支持 | 添加 -target wasm 编译选项,生成 .wasm |

✅ 在浏览器中运行 hello.wasm,输出相同 |

2‑3 周 |

| 5. 并行模型 | 实现 并行 块,使用 OpenMP 或 Rayon |

✅ 并行 示例跑出多核加速 |

2 周 |

| 6. AI 接口 | 集成 ONNX Runtime / ggml,提供 加载模型、推理 |

✅ 能在本地调用 sentiment.onnx 并返回结果 |

2‑4 周 |

| 7. FFI | 实现 调用_cpp、调用_py,生成 C 绑定 |

✅ 调用 C++ sqrt、Python numpy.sum |

3 周 |

| 8. 标准库 & 文档 | 编写中文手册、示例项目、教学视频 | 完成《MyChinese 编程语言手册》 | 4‑6 周 |

| 9. IDE 插件 | VS Code LSP 实现,提供语法高亮、自动完成 | ✅ 发布 VS Code Marketplace | 2‑3 周 |

| 10. 社区 & 教学 | 针对小学阶段设计 Blockly 栈式可视化编辑器 | 完成可视化编程与源码同步 | 持续进行 |

总计约 5‑6 个月(全职),如采用 分模块并行(比如后端与前端交叉进行),可以更快。

6️⃣ 常见坑 & 解决方案

| 痛点 | 说明 | 对策 |

|---|---|---|

| 中文关键字的编码冲突 | 某些编辑器对全角/半角标点识别不一致 | 统一采用 UTF‑8,在词法中把全角空格、全角逗号映射为普通空格、逗号 |

| LLVM 对中文符号的支持 | LLVM‑IR 中函数名只能是 ASCII | 在前端生成 内部唯一 ID(如 f_0x1234),同时保持一张 映射表 用于错误信息和调试 |

| Wasm 中的线程/并行 | WebAssembly 原生只在 SharedArrayBuffer 环境下支持线程 | 采用 Web Workers + wasm‑threads 编译选项,或在非浏览器环境(Node、wasmtime)直接使用多线程 |

| AI 库体积过大 | ONNX 或 TensorFlow 需要数十 MB,使 Wasm 文件膨胀 | 使用 ggml(C 单文件)或 TensorFlow Lite(裁剪后)进行模型推理;模型文件可分离加载 |

| 跨平台 FFI 打包 | Windows、Linux、macOS 动态库命名/加载差异 | 抽象出统一的 load_library(name),内部调用 LoadLibrary/dlopen/NSBundle |

| 教学难度 | 小学生可能不熟悉 递归、闭包 等概念 | 提供 可视化块(Blockly) → 自动生成对应 S‑Expression,先让学生拖拽块再看源码 |

| 错误提示不友好 | Lisp 语法错误往往只提示“unexpected token”。 | 在 Parser 中记录 行/列、父节点,并生成 彩色提示(如 ❌ 第 12 行:缺少闭括号) |

7️⃣ 示例项目结构

mychinese/

├─ Cargo.toml # Rust 主项目

├─ src/

│ ├─ main.rs # CLI入口

│ ├─ lexer.rs # Logos / ANTLR自动生成

│ ├─ parser.rs # LALRPOP或手写parser

│ ├─ ast.rs # AST定义

│ ├─ typecheck.rs # 符号表 + 类型检查

│ ├─ codegen/

│ │ ├─ mod.rs

│ │ ├─ llvm.rs # Inkwell代码生成

│ │ └─ wasm.rs # Wasm特化

│ ├─ runtime/

│ │ ├─ lib.rs

│ │ ├─ parallel.rs # Rayon实现并行块

│ │ └─ ffi.rs # C++/Python FFI封装

│ └─ stdlib/

│ ├─ math.mc

│ ├─ ai.mc

│ └─ concurrent.mc

├─ lsp/ # Language Server Protocol 实现

│ └─ ...

├─ examples/

│ ├─ hello.mc

│ ├─ parallel_sum.mc

│ └─ sentiment.mc

├─ tests/

│ └─ integration_test.rs

└─ docs/

└─ manual.md

Copy8️⃣ 生态合作与社区建议

- 邀请教育机构:与 小学信息科技老师 合作,先在课堂里试运行“块式 → 代码”双向教学。

- 开源许可证:采用 Apache‑2.0,兼容商业闭源插件。

- 贡献指南:准备

CONTRIBUTING.md,尤其是 添加新关键字或标准库模块 的流程。 - 定期 Hackathon:鼓励学生提交 小游戏、AI 小模型、硬件控制(如 Arduino)示例。

- 多语言文档:中文是主语言,配套 英文(方便海外中文学习者)和 简体/繁体 两种版本。

9️⃣ 小结——一步到位的实现要点

| 步骤 | 核心代码片段 | 关键工具 |

|---|---|---|

| 词法 | logos::Lexer 或 ANTLR4 生成器 |

logos, antlr4rs |

| 语法 | LALRPOP 定义 def_expr : "定义" IDENT "(" param_list ")" expr |

lalrpop |

| AST → LLVM | inkwell::builder.build_call(fn, args, "call"); |

inkwell |

| 并行 | rayon::prelude::*; tasks.par_iter().for_each(...); |

rayon |

| Wasm | llc -march=wasm32 -filetype=obj + wasm-ld |

llvm, wasm-ld |

| AI | OrtCreateSession(...); OrtRun(...); |

onnxruntime-sys |

| FFI | extern "C" fn call_cpp(lib: *const c_char, fn: *const c_char, ...) |

libloading, cbindgen |

| CLI | structopt 解析 myc src.mc -target wasm -o out.wasm |

clap / structopt |

| IDE | tower-lsp 实现 textDocument/completion |

tower-lsp |

核心价值:利用 LLVM 让语言的性能几乎等同 C++,借助 Rust 的安全性快速实现前端、后端、并行、FFI,最终只需要在 语法层面 替换为中文关键字,即可实现 “普通小学文化也能学会” 的编程体验。

祝你项目顺利 🚀,如果在实际实现的任何细节上卡住(比如 ANTLR 语法写法、LLVM‑IR 类型映射、Wasm 多线程)随时来聊!祝代码写得开心,学生们玩得开心!

现在的AI真的不得了,这是真的能抵一个架构师啊!

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)